Участник:Руфина Третьякова/Хранение ненулевых элементов разреженных матриц. Умножение разреженной матрицы на вектор: различия между версиями

Trrufina (обсуждение | вклад) |

Trrufina (обсуждение | вклад) |

||

| Строка 160: | Строка 160: | ||

# все процессоры вычисляют произведение своего блока матрицы на вектор | # все процессоры вычисляют произведение своего блока матрицы на вектор | ||

# управляющий процессор собирает результаты | # управляющий процессор собирает результаты | ||

| − | Данный алгоритм несмотря на кажщуюся простоту оказывается весьма неэффективен, так как время пересылок оказывается на порядки больше времени вычисления. Более того, при большом количестве процессоров время выполнения параллельной программы оказывается больше времени выполнения последовательной программы. | + | Данный алгоритм несмотря на кажщуюся простоту оказывается весьма неэффективен, так как время пересылок оказывается на порядки больше времени вычисления. Более того, при большом количестве процессоров время выполнения параллельной программы оказывается больше времени выполнения последовательной программы. Производительность и эффективность работы данного алгоритма показаны на рисунках 1 и 2. |

<div><ul> | <div><ul> | ||

<li style="display: inline-block;"> [[File:perf_drto.png|thumb|none|800px|Рисунок 1: производительность умножения разреженной матрицы на вектор при считывании управляющим процессором (время считывания и пересылок учтено)]] </li> | <li style="display: inline-block;"> [[File:perf_drto.png|thumb|none|800px|Рисунок 1: производительность умножения разреженной матрицы на вектор при считывании управляющим процессором (время считывания и пересылок учтено)]] </li> | ||

<li style="display: inline-block;"> [[File:effc_drto.png|thumb|none|800px|Рисунок 2: эффективность умножения разреженной матрицы на вектор при считывании управляющим процессором (время считывания и пересылок учтено)]] </li> | <li style="display: inline-block;"> [[File:effc_drto.png|thumb|none|800px|Рисунок 2: эффективность умножения разреженной матрицы на вектор при считывании управляющим процессором (время считывания и пересылок учтено)]] </li> | ||

</ul></div> | </ul></div> | ||

| + | |||

| + | Проблема многих современных параллельных вычислительных систем заключается в том, что скорость обмена между процессорами существенно отстает от скорости произведения операций самими процессорами, а также число каналов связи много меньше числа процессоров, отчего возникают дополнительные задержки. Потому необходимо создавать алгоритмы которые по возможности будут использовать меньшее число операций пересылок данных. | ||

| + | Улучшенный алгоритм: | ||

| + | # каждый процессор вычисляет блок матрицы (индексы строк) с которым ему предстоит работать в зависимости от своего порядкового номера | ||

| + | # каждый процессор генерирует или считывает (при помощи процедур параллельного чтения) свой блок матрицы, и вектор | ||

| + | # каждый процессор вычисляет произведение своего блока матрицы на вектор | ||

| + | # управляющий (нулевой) процессор собирает результат или же каждый процессор записывает свою часть результата (при помощи процедур параллельной записи) | ||

| + | |||

| + | Данный алгоритм отличается лучшим быстродействием (по крайней мере, время работы параллельной программы уменьшается с увеличением числа процессоров) | ||

<div><ul> | <div><ul> | ||

| − | <li style="display: inline-block;"> [[File:perf_drtc.png|thumb|none|800px| | + | <li style="display: inline-block;"> [[File:perf_drtc.png|thumb|none|800px|Рисунок 3: производительность умножения разреженной матрицы на вектор при параллельном считывании (время считывания и пересылок учтено)]] </li> |

| − | <li style="display: inline-block;"> [[File:effc_drtc.png|thumb|none|800px| | + | <li style="display: inline-block;"> [[File:effc_drtc.png|thumb|none|800px|Рисунок 4: эффективность умножения разреженной матрицы на вектор при параллельном считывании (время считывания и пересылок учтено)]] </li> |

</ul></div> | </ul></div> | ||

Версия 16:51, 9 ноября 2016

| Эта работа прошла предварительную проверку Дата последней правки страницы: 09.11.2016 Данная работа соответствует формальным критериям. Проверено Dan. |

| Умножение разреженной матрицы на вектор | |

| Последовательный алгоритм | |

| Последовательная сложность | nnz |

| Объём входных данных | 2(nnz+n)+1 |

| Объём выходных данных | n |

| Параллельный алгоритм | |

| Высота ярусно-параллельной формы | O(n) |

| Ширина ярусно-параллельной формы | O(n) |

Авторы статьи: Третьякова Р. М. (группа 603), Буторина Е. В. (группа 603)

Руфина Третьякова отвечает за программную реализацию алгоритма, Екатерина Буторина - за написание статьи.

Содержание

- 1 ЧАСТЬ. Свойства и структура алгоритма

- 1.1 Общее описание алгоритма

- 1.2 Математическое описание алгоритма

- 1.3 Вычислительное ядро алгоритма

- 1.4 Макроструктура алгоритма

- 1.5 Схема реализации последовательного алгоритма

- 1.6 Последовательная сложность алгоритма

- 1.7 Информационный граф

- 1.8 Ресурс параллелизма алгоритма

- 1.9 Входные и выходные данные алгоритма

- 1.10 Свойства алгоритма

- 2 ЧАСТЬ. Программная реализация алгоритма

- 2.1 Особенности реализации последовательного алгоритма

- 2.2 Локальность данных и вычислений

- 2.3 Возможные способы и особенности параллельной реализации алгоритма

- 2.4 Масштабируемость алгоритма и его реализации

- 2.5 Динамические характеристики и эффективность реализации алгоритма

- 2.6 Выводы для классов архитектур

- 2.7 Существующие реализации алгоритма

- 3 Литература

1 ЧАСТЬ. Свойства и структура алгоритма

1.1 Общее описание алгоритма

Разрежённая матрица — это матрица с преимущественно нулевыми элементами. В противном случае, если бо́льшая часть элементов матрицы ненулевые, матрица считается плотной. Среди специалистов нет единства в определении того, какое именно количество ненулевых элементов делает матрицу разрежённой. Разные авторы предлагают различные варианты. Огромные разрежённые матрицы часто возникают при решении таких задач, как дифференциальное уравнение в частных производных или операции с графами. При хранении и преобразовании разрежённых матриц в компьютере бывает полезно, а часто и необходимо, использовать специальные алгоритмы и структуры данных, которые учитывают разрежённую структуру матрицы. Операции и алгоритмы, применяемые для работы с обычными, плотными матрицами, применительно к большим разрежённым матрицам работают относительно медленно и требуют значительных объёмов памяти. Однако разрежённые матрицы могут быть легко сжаты путём записи только своих ненулевых элементов, что снижает требования к компьютерной памяти. Сложность операции с разреженными матрицами чаще всего определяется не их размером но числом ненулевых элементов. Далее будет показано, что умножение разреженной матрицы на плотный вектор можно произвести ровно за столько умножений сколько в матрице ненулевых элементов.

1.2 Математическое описание алгоритма

Исходные данные: разреженная матрица M^{n*n}, вектор x^n

Наиболее удобным форматом для вычисления произведения матрицы на вектор является "Compressed Sparse Row" или сокращенно CSR-формат.

Рассмотрим CSR-представление разреженной матрицы: пусть число ненулевых элементов матрицы равно nnz CSR-формат представляет матрицу M в виде 3-х одномерных массивов:

массив A размера nnz содержит ненулевые значения матрицы, JA размера nnz - номера столбцов ненулевых элементов., IA размера n- содержит номер с которого начинается описание элементов строки в массивах A и JA.

Этот формат позволяет производить перемножение матрицы M на вектор x за O(nnz) умножений и сложений. Если при умножении плотной матрицы на вектор каждый элемент результата определяется по формуле y_i = \sum_{k = 1}^{n} A_{ik} x_k, то в случае разреженной матрицы достаточно выполнять умножения только для ненулевых элементов A_ik, которые хранятся в массиве A в части соответствующей строке i (элементы с индексами от IA_i до IA_{i+1}). Необходимо также знать на какой элемент вектора должен быть домножен данный ненулевой элемент массива, то есть нужен столбцовый индекс каждого элемента A. Для этого используется массив JA. Таким образом, каждый элемент итогового вектора определятся формулой

- y_i = \sum_{k = IA_i}^{IA_{i+1}} A_k x_{JA_k}

Нетрудно заметить, что общее число операций умножения равно числу элементов A, то есть числу ненулевых элементов разреженной матрицы.

Например, это разреженная матрица с 4-мя ненулевыми элементами

- \begin{pmatrix} 0 & 0 & 0 & 0 \\ 2 & 0 & 0 & 1 \\ 0 & 0 & 3 & 0 \\ 0 & 4 & 0 & 0 \\ \end{pmatrix},

представляемая в формате CSR

A = [ 2 1 3 4 ] IA = [ 0 0 2 3 4 ] JA = [ 0 3 2 1 ]

домножим ее на вектор

x = [ 5 6 7 8 ]

получим

y[0] = 0 y[1] = a[0]*x[0] + a[1]*x[3] = 18 y[2] = a[2]*x[2] = 21 y[3] = a[3]*x[1] = 24

Алгоритм умножения матрицы на вектор полностью детерминирован и не зависит от порядка хранения элементов принадлежащих одной строке.

1.3 Вычислительное ядро алгоритма

Вычислительным ядром алгоритма является формула умножения разреженной матрицы на плотный вектор:

- y_i = \sum_{k = IA_i}^{IA_{i+1}} A_k x_{JA_k}

для всех i = 1,n

1.4 Макроструктура алгоритма

Псевдокод алгоритма:

Входные данные:

число строк матрицы n;

разреженная матрица в формате CSR:

строчные указатели IA,

столбцовые указателиJA,

ненулевые элементы A;

вектор x.

Выходные данные: произведение матрицы на вектор y.

read CSR n, IA, JA, A;

read x

for i = 1,n:

for k = IA(i), IA(i+1)-1:

y(i) += A(k)*x(JA(k));

write y;

1.5 Схема реализации последовательного алгоритма

Метод можно описать следующим образом:

- привести матрицу M к формату CSR

- для i от 0 до n-1 вычислить y_i по формуле y_i = \sum_{k = IA_i}^{IA_{i+1}} A_k x_{JA_k}

1.6 Последовательная сложность алгоритма

Для вычисления матрично-векторного произведения матрицы размера n*n и вектора размера n в последовательном варианте требуется:

- nnz сложений,

- nnz умножений.

1.7 Информационный граф

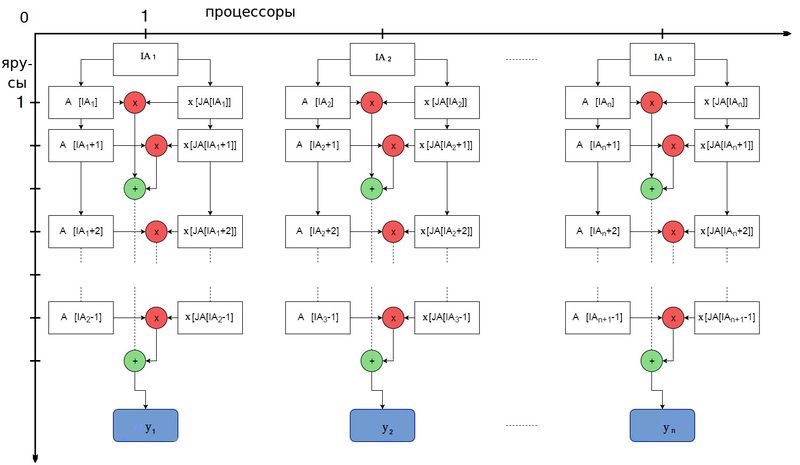

Для того чтобы построить информационный граф рассмотрим процесс вычисления значения одного элемента результирующего вектора y_i. Число последовательных ярусов равно числу последовательных операций -- AI_{i+1} - AI_i (в данном случае умножение и сложение будем считать за одну операцию). Если же вычисления всех y_i производить параллельно, на каждом ярусе будет производиться n операций.

1.8 Ресурс параллелизма алгоритма

Возможность параллельной реализации алгоритма появляется благодаря независимости вычисления каждого элемента результирующего вектора y_i. Предположим, что имеется неограниченное число процессоров (теоретически, для максимальной эффективности требуется n процессоров). Каждый процессор работает с одной строкой разреженной матрицы и хранит в памяти только те части массивов AJ и A , которые соответствуют данной строке. Вектор x хранится в памяти всех процессоров. Таким образом достигается экономия памяти (объем данных для i-ого процессора 2(AI_{i+1} - AI_i) + n ). На данном процессоре выполняется AI_{i+1} - AI_i последовательных операций умножения и сложения. Число ярусов для i-ого процессора равно AI_{i+1} - AI_i . Поскольку изначальная разреженная матрица имеет произвольную структуру, число ярусов на различных процессорах может быть различно. В худшем случае (если в строке все элементы ненулевые) число ярусов будет равно n.

Таким образом, для алгоритма умножения разреженной матрицы на плотный вектор в параллельном варианте требуется последовательно выполнить:

- не более чем n ярусов умножений и сложений,

- в каждом из ярусов не более чем n операций.

При классификации по высоте ЯПФ, таким образом, алгоритм умножения матрицы на вектор относится к алгоритмам с линейной сложностью. При классификации по ширине ЯПФ его сложность также будет линейной.

Замечание: если число процессоров k меньше числа строк, но отношение \frac{n}{k} = c является константой, то каждый процессор вычисляет c элементов результирующего вектора, и число ярусов не более чем cn. Таким образом, предыдущие оценки сложности сохранятся.

1.9 Входные и выходные данные алгоритма

Входными данными алгоритма являются:

- размер разреженной матрицы n ;

- вектор AI размерности n+1 ;

- вектор AJ размерности nnz ;

- вектор A размерности nnz ;

- вектор x размерности n .

Суммарная размерность входных данных: 2(nnz + n) + 1

Выходными данными является

- вектор y размерности n .

Объем выходных данных: n .

1.10 Свойства алгоритма

Если размерность матрицы n, число ненулевых элементов nnz, для вычисления используется k процессоров тогда:

- Каждый процессор оперирует с \frac{n}{k} строками, в каждой из которых примерно \frac{nnz}{n} элементов. Параллельная сложность алгоритма - O(\frac{nnz}{k}).

- Вычислительная мощность алгоритма (отношение числа операций к суммарному объему входных и выходных данных) - O(\frac{nnz}{2nnz + 3n}) = O(1) - для последовательного алгоритма; O(\frac{nnz}{n} / (2\frac{nnz}{n} + n)) = O(1) - для параллельного алгоритма.

2 ЧАСТЬ. Программная реализация алгоритма

2.1 Особенности реализации последовательного алгоритма

2.2 Локальность данных и вычислений

2.3 Возможные способы и особенности параллельной реализации алгоритма

2.4 Масштабируемость алгоритма и его реализации

Наитивная реализация алгоритма следующая:

- один процессор назначается управляющим

- управляющий процессор считывает или генерирует (если матрица задается известной формулой) матрицу в CSR формате [ AI, AJ, A ]

- управляющий процессор считывает или генерирует вектор x

- управляющий процессор разделяет матрицу на блоки в зависимости от числа процессоров и рассылает остальным процессорам строки матрицы и вектор

- все процессоры вычисляют произведение своего блока матрицы на вектор

- управляющий процессор собирает результаты

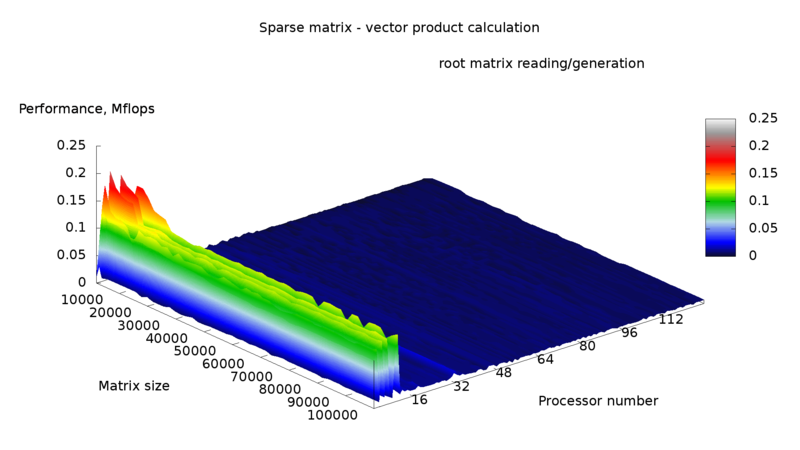

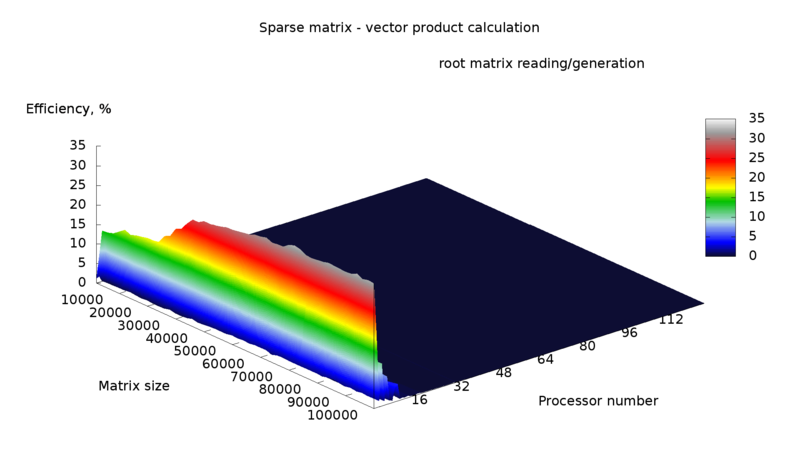

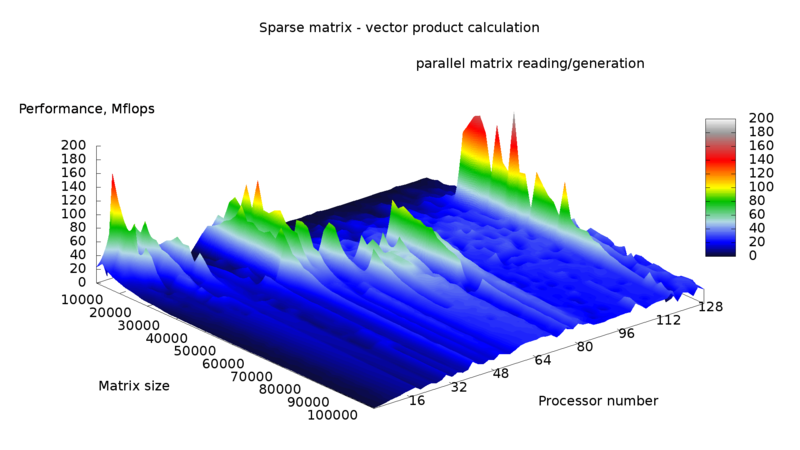

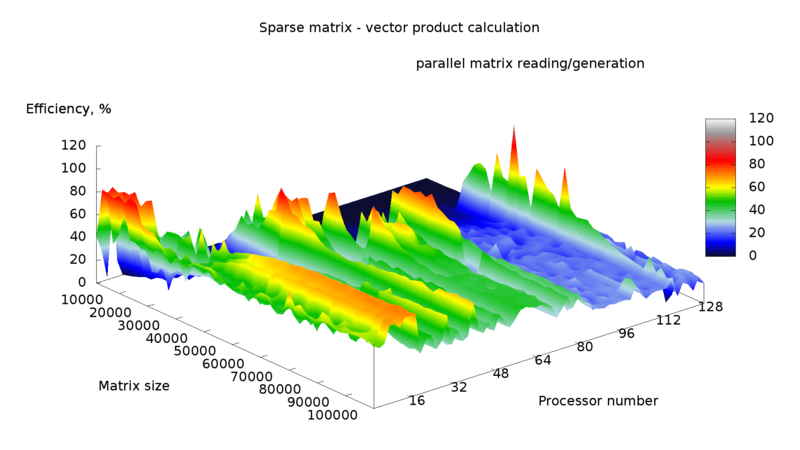

Данный алгоритм несмотря на кажщуюся простоту оказывается весьма неэффективен, так как время пересылок оказывается на порядки больше времени вычисления. Более того, при большом количестве процессоров время выполнения параллельной программы оказывается больше времени выполнения последовательной программы. Производительность и эффективность работы данного алгоритма показаны на рисунках 1 и 2.

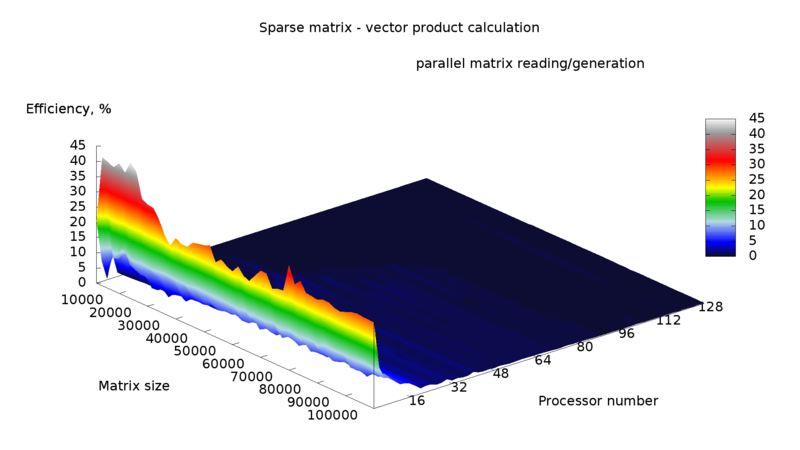

Проблема многих современных параллельных вычислительных систем заключается в том, что скорость обмена между процессорами существенно отстает от скорости произведения операций самими процессорами, а также число каналов связи много меньше числа процессоров, отчего возникают дополнительные задержки. Потому необходимо создавать алгоритмы которые по возможности будут использовать меньшее число операций пересылок данных. Улучшенный алгоритм:

- каждый процессор вычисляет блок матрицы (индексы строк) с которым ему предстоит работать в зависимости от своего порядкового номера

- каждый процессор генерирует или считывает (при помощи процедур параллельного чтения) свой блок матрицы, и вектор

- каждый процессор вычисляет произведение своего блока матрицы на вектор

- управляющий (нулевой) процессор собирает результат или же каждый процессор записывает свою часть результата (при помощи процедур параллельной записи)

Данный алгоритм отличается лучшим быстродействием (по крайней мере, время работы параллельной программы уменьшается с увеличением числа процессоров)

2.5 Динамические характеристики и эффективность реализации алгоритма

2.6 Выводы для классов архитектур

2.7 Существующие реализации алгоритма

Последовательная реализация имеется в пакете SPARSKIT [1], Python.Scipy [2]

Параллельный алгоритм реализован в библиотеке Matlab [3], Intel MKL [4]

3 Литература

[1] С. Писсанецки. Технология разреженных матриц. Изд. Мир, 1988.

[2] В. В. Воеводин, Вл.В. Воеводин. Параллельные вычисления. – СПб.: БХВ - Петербург, 2002.