Участник:Grinch96/QR-факторизация методом Грама-Шмидта с последующей реортогонализацией

Автор: Г. А. Балыбердин

Содержание

- 1 Свойства и структура алгоритма

- 1.1 Общее описание алгоритма

- 1.2 Математическое описание алгоритма

- 1.3 Вычислительное ядро алгоритма

- 1.4 Макроструктура алгоритма

- 1.5 Схема реализации последовательного алгоритма

- 1.6 Последовательная сложность алгоритма

- 1.7 Информационный граф

- 1.8 Ресурс параллелизма алгоритма

- 1.9 Входные и выходные данные алгоритма

- 1.10 Свойства алгоритма

- 2 Программная реализация алгоритма

- 2.1 Особенности реализации последовательного алгоритма

- 2.2 Локальность данных и вычислений

- 2.3 Возможные способы и особенности параллельной реализации алгоритма

- 2.4 Масштабируемость алгоритма и его реализации

- 2.5 Динамические характеристики и эффективность реализации алгоритма

- 2.6 Выводы для классов архитектур

- 2.7 Существующие реализации алгоритма

- 3 Литература

1 Свойства и структура алгоритма

1.1 Общее описание алгоритма

Пусть A = (a_1, ..., a_n) - вещественная матрица n × n, определитель которой не равен 0. Во многих приложениях требуется решать линейную систему Ax=b c плохо-обусловленной матрицей A. При решении данной задачи, чтобы не увеличивать число обусловленности матрицы A, ее можно представить в виде A=QR, где матрица Q \in \mathbb{R}^{n×n} состоит из ортонормированных строк, а матрица R \in \mathbb{R}^{n×n} является верхнетреугольной. В итоге мы получаем так называемую QR-факторизацию.

Чтобы построить QR-факторизацию можно воспользоваться процессом ортогонализации Грама-Шмидта[1], однако в условиях машинной арифметики, матрица Q может получиться далекой от ортогональной.Чтобы этого избежать, на определенных итерациях нужно проводить процесс реортогонализации [2].

1.2 Математическое описание алгоритма

Исходные данные: квадратная матрица A порядка n (элементы a_{ij}), определитель которой не равен 0.

Вычисляемые данные: верхнетреугольная матрица R порядка n (элементы r_{ij}), унитарная матрица Q порядка n (элементы q_{ij}); выполняется соотношение QR=A.

Формулы процесса ортогонализации:

\begin{align} & p_{j} = a_{j} - \sum_{i=1}^{j-1} q_{i} (q_{i}^{T} a_{j}), \\ & q_{j} = p_{j} / ||p_{j}||_{2}, \\ & r_{ij} = q_{i}^{T} a_{j},\quad i = 1, \ldots , j - 1.\\ \end{align}

Здесь q_{i}, \, a_{i} столбцы матриц Q, \, A соответственно.

На m-ом шаге получаем p_{m} \in \mathbb{R}^{n}. Если ||a_{m}||_{2}/||p_{m}||_{2} \gt k, запускается процесс реортогонализации. k произвольная и задает точность ортогональности матрицы Q. В посвященной методу реортогонализации статье [3] k рекомендуется брать равным 10, однако приводятся примеры алгоритмов, где k=\sqrt{2} или k=\sqrt{5}. Мы исследуем k=10.

Суть процесса реортогонализации - это процесс ортогонализации Грама-Шмидта, примененный повторно к вектору p_{m} на m-оm шаге алгоритма. Более формально:

\begin{align} & \tilde{p}_{m} = p_{m} - \sum_{i=1}^{m-1} q_{i} (q_{i}^{T} p_{m}), \\ & q_{m} = \tilde{p}_{m} / ||\tilde{p}_{m}||_{2}, \\ & \tilde{r}_{mj} = q_{j}^{T} p_{m}, \quad j = 1, \ldots , m - 1, \\ & r_{mj} = \tilde{r}_{mj} + r_{mj}^{0}, \quad j = 1, \ldots , m - 1, \\ & r_{mm} = ||\tilde{p}_{m}||_{2}. \end{align}

Здесь \tilde{q}_{i} столбцы матриц \tilde{Q}_{m}, r_{mj}^{0} - элементы матрицы R, вычисленные до реортогонализации.

1.3 Вычислительное ядро алгоритма

Вычислительное ядро алгоритма, если не требуется реортогонализация, состоит из вычисления:

- \dfrac{n(n+1)}{2} скалярных произведений векторов, включая вычисление длины вектора;

- \dfrac{(n-1)n}{2} умножений векторов на число.

На каждом шаге реортогонализации добавляется j-1 вычислений скалярных произведений векторов на число и столько же умножений вектора на число. Здесь реортогонализация производится на j-ом шаге. Однако сколько раз алгоритм будет реортогонализовывать вектора зависит от свойств матрицы.

1.4 Макроструктура алгоритма

Как записано и в описании ядра алгоритма, основную часть процесса составляют скалярные произведения векторов и умножения вектора на число:

\begin{align} & p_{j} = a_{j} - \sum_{i=1}^{j-1} q_{i} (q_{i}^{T} a_{j}), \\ & q_{j} = p_{j} / ||p_{j}||_{2}. \end{align}

как если алгоритм реортогонализует повторно вектора, так и без реортогонализаций.

1.5 Схема реализации последовательного алгоритма

Последовательность исполнения процесса следующая:

1. q_1 = \frac{a_1}{||a_1||_2}

Далее для всех i = 2, n :

2. r_{ij} = q_{j}^{T} a_{i},\quad j = 1, \ldots , i - 1

3. p_{i} = a_{i} - \sum_{j=1}^{i-1} q_{j} r_{ij}

Если ||a_{i}||_{2}/||p_{i}||_{2} \gt k, выполнить 4, 5, 6. Иначе перейти сразу к 7:

4. r_{ij}^{0} = q_{j}^{T} p_{i},\quad j = 1, \ldots , i - 1

5. p_{i} = p_{i} - \sum_{j=1}^{i-1} q_{j} r_{ij}^{0}, \quad j = 1, \ldots , i - 1

6. r_{ij} = r_{ij}^{0} + r_{ij},\quad j = 1, \ldots , i - 1

7. r_{ii} = ||p_{i}||_{2}

8. q_{i} = p_{i} / r_{ii}

Здесь (как и везде) под второй нормой подразумевается:

||x||_2 = \sqrt{x_1^2 + x_2^{2} + \ldots + x_n^2}

1.6 Последовательная сложность алгоритма

Для факторизации матрицы порядка n процессом Грама-Шмидта в последовательном варианте без реортогонализации требуется:

- n извлечений квадратного корня,

- n делений,

- (n-1)(n^2+2n-1) сложений (вычитаний),

- n(n^2+2n-2) умножений.

Если реортогонализация работает на каждом шаге (чего никогда не случается, однако предположим худший случай), то количество всех операций удвоится. Таким образом, умножения и сложения (вычитания) составляют основную часть алгоритма.

При классификации по последовательной сложности, процесс ортогонализации Грама-Шмидта с реортогонализацией относится к алгоритмам с кубической сложностью.

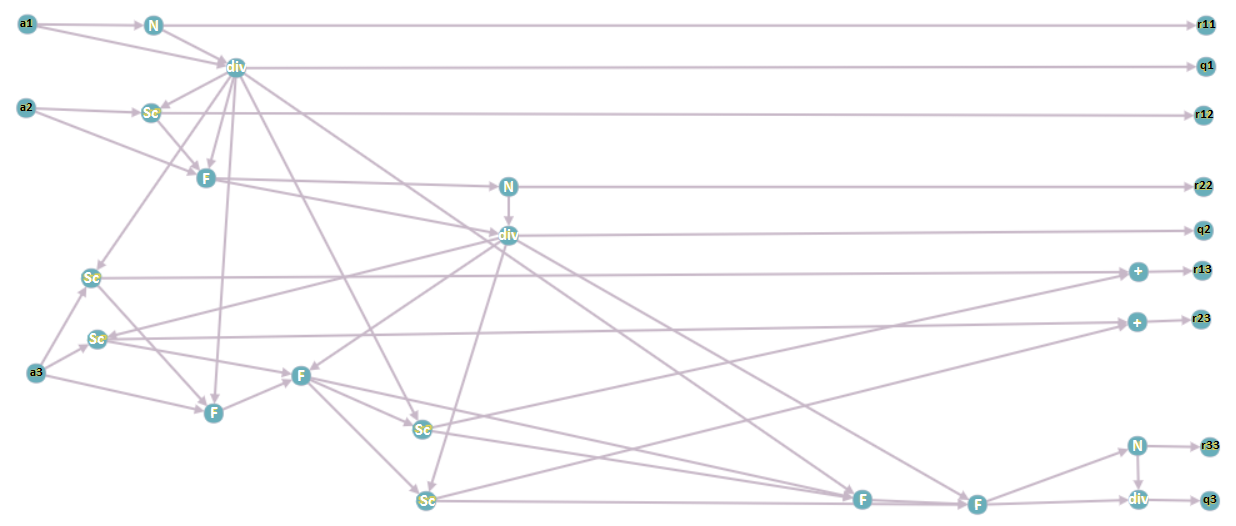

1.7 Информационный граф

Опишем вершины информационного графа.

1. a_i, \; i = 1 \ldots n — столбцы исходной матрицы A ; подаются на вход программе.

2. N — операция взятия нормы вектора.

3. div — операция деления вектора на число.

4. Sc — операция взятия скалярного произведения двух векторов.

5. F — операция вычитания из вектора произведение числа на вектор.

6. + — операция суммирования двух чисел.

7. r_{ij} , q_i, \; i = 1 \ldots n, \; j = 1 \ldots n — элементы матрицы R и столбцы матрицы Q соответственно; выходные данные программы.

Информационный граф построен для матрицы размерности 3 при выполнении реортогонализации для третьего вектора.

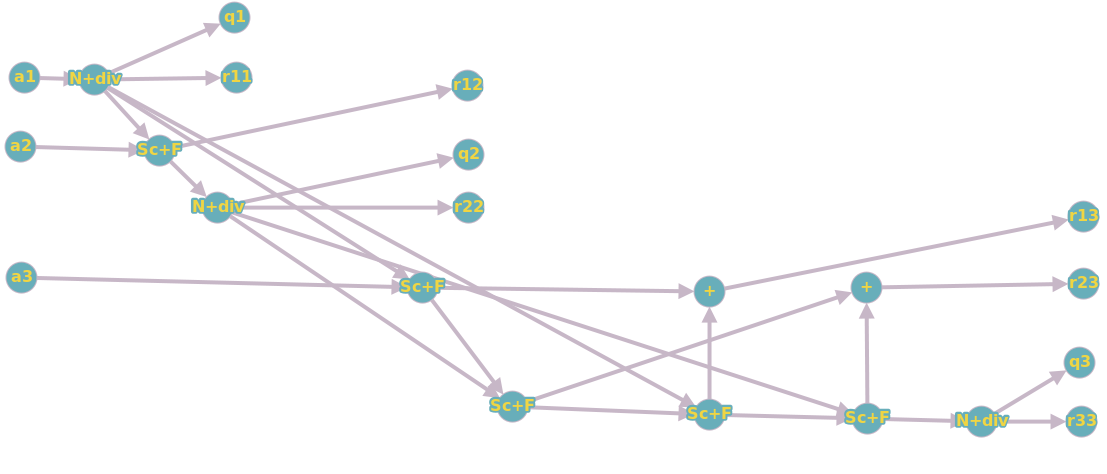

Если объединить вершины N и div, Sc и F (вершины будут означать суперпозиции соответствующих операций), то получится следующий, чуть более простой для понимания, граф:

1.8 Ресурс параллелизма алгоритма

В последовательной версии алгоритма двумя самыми трудоемкими операциями являются подсчет скалярных произведений и вычисление вектора, ортогонального предыдущим. Мы хотим добиться, чтобы каждый процессор считал "кусок" этих операций, однако также для ускорения работы программы нужно минимизировать число пересылок между процессорами. Пусть k - количество процессоров. Предлагается разбить исходную матрицу A на k блоков по \frac{n}{k} столбцов в каждом ( n - размерность задачи), тогда каждый процессор будет решать задачу на "своем подпространстве". Таким образом мы добьемся количества пересылок порядка O(kn) , и параллельная сложность алгоритма составит O( \frac{n^3}{k} ) .

1.9 Входные и выходные данные алгоритма

Входные данные: невырожденная матрица A (элементы a_{ij}).

Объём входных данных: n^2.

Выходные данные: верхняя треугольная матрица R (элементы r_{ij}), унитарная матрица Q (элементы q_{ij}).

Объём выходных данных: \frac{n (n + 1)}{2} + n^2 (в силу треугольности матрицы R достаточно хранить только ее ненулевые элементы).

1.10 Свойства алгоритма

2 Программная реализация алгоритма

2.1 Особенности реализации последовательного алгоритма

2.2 Локальность данных и вычислений

2.3 Возможные способы и особенности параллельной реализации алгоритма

2.4 Масштабируемость алгоритма и его реализации

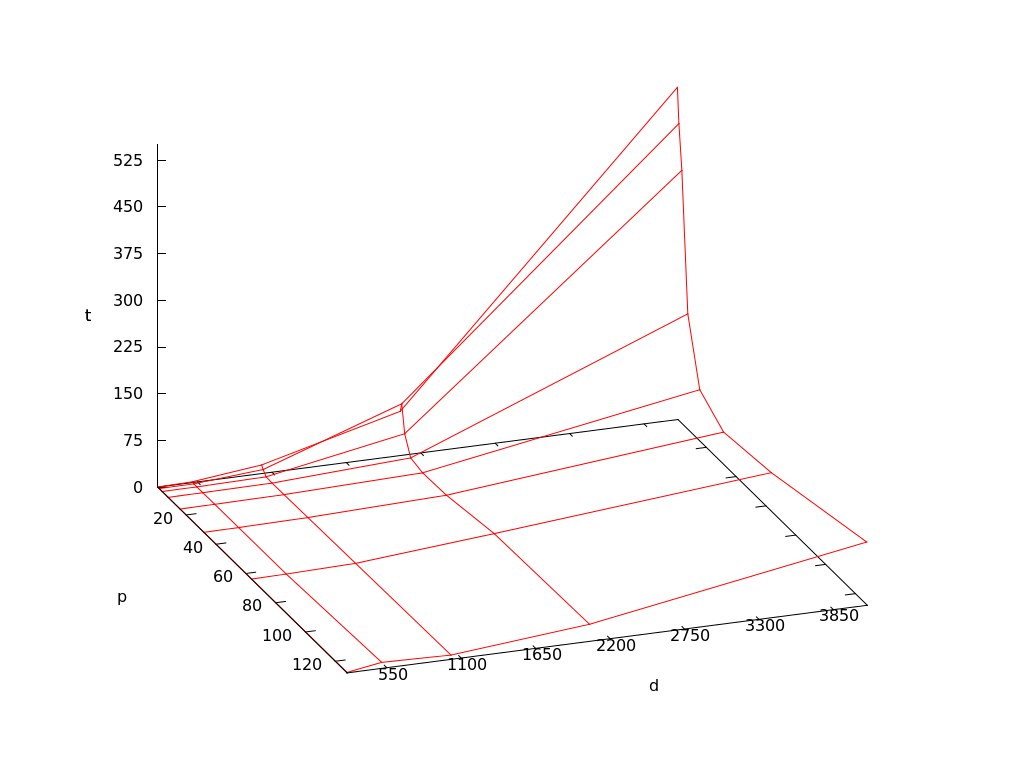

Исследование проводилось на суперкомпьютере "Ломоносов" Суперкомпьютерного комплекса Московского университета.

Набор и границы значений изменяемых параметров запуска реализации алгоритма:

число процессоров 2^k, где k пробегает от 0 до 7;

размер матрицы n^p, где p пробегает от 8 до 12.

На следующем рисунке приведен график времени работы алгоритма (t) в зависимости от количества процессов (p) и размерности задачи (d):

Сильная масштабируемость на графике наблюдается в тех случаях, когда время пересылок много меньше времени работы процесса. Когда время, затраченное на пересылки, эквивалентно времени работы процесса, на графике мы можем наблюдать слабую масштабируемость. Если же время пересылок начинает превышать время работы процессоров, смысл от параллельности теряется, так как при увеличении числа процессов увеличивается время подсчета.

2.5 Динамические характеристики и эффективность реализации алгоритма

2.6 Выводы для классов архитектур

2.7 Существующие реализации алгоритма

Существует масса реализаций метода Грама-Шмидта без реортогонализации, о которых говорится, например, здесь. Про реализации с реортогонализацией информации нет.

3 Литература

<references \>

[[Категория:]]

[[Категория:]]

- ↑ Тыртышников Е.Е. Методы численного анализа // М.: 2006. 83 с.

- ↑ Luc Giraud, Julien Langou, Miroslav Rozložník, Jasper van den Eshof. Rounding error analysis of the classical Gram-Schmidt orthogonalization process // Springer-Verlag, 2005.

- ↑ Luc Giraud and Jilien Langou. A robust criterion for the modified Gram–Schmidt algorithm with selective reorthogonalization // Society for Industrial and Applied Mathematic, 2003.