Участник:Ivan kolosov/Алгоритм кластеризации, основанный на сетях Кохоннена

| Эта работа прошла предварительную проверку Дата последней правки страницы: 30.11.2016 Данная работа соответствует формальным критериям. Проверено ASA. |

Основные авторы описания: И.Ю.Колосов.

Содержание

- 1 Свойства и структура алгоритма

- 1.1 Общее описание алгоритма

- 1.2 Математическое описание алгоритма

- 1.3 Вычислительное ядро алгоритма

- 1.4 Макроструктура алгоритма

- 1.5 Схема реализации последовательного алгоритма

- 1.6 Последовательная сложность алгоритма

- 1.7 Информационный граф

- 1.8 Ресурс параллелизма алгоритма

- 1.9 Входные и выходные данные алгоритма

- 1.10 Свойства алгоритма

- 2 Программная реализация алгоритма

- 2.1 Особенности реализации последовательного алгоритма

- 2.2 Локальность данных и вычислений

- 2.3 Возможные способы и особенности параллельной реализации алгоритма

- 2.4 Масштабируемость алгоритма и его реализации

- 2.5 Динамические характеристики и эффективность реализации алгоритма

- 2.6 Выводы для классов архитектур

- 2.7 Существующие реализации алгоритма

- 3 Литература

1 Свойства и структура алгоритма

1.1 Общее описание алгоритма

Задача кластеризации — это задача, в которой требуется разбить объекты во входных данных на группы, иначе называемые кластерами, таким образом, что внутри каждого кластера объекты в каком-то смысле похожи, а объекты в разных кластерах в каком-то смысле различны. Для этой задачи финским ученым Теуво Кохоненом в 80-е годы был разработан алгоритм кластеризации, основанный на использовании нейронной сети.

Алгоритм кластеризации, основанный на сетях Кохонена, предназначен для кластеризации вещественных векторов.[1] В основе алгоритма лежит однослойная нейронная сеть, называемая картой Кохонена. Нейроны образуют сетку, в которой каждый нейрон имеет свои координаты. У каждого нейрона есть вектор весов, размерность которого равна размерности входных векторов. Все узлы входного слоя соединены с каждым из нейронов. Всюду в данной статье будем считать, что сетка нейронов двумерная, хотя ее размерность может выбираться произвольно, в том числе она может быть одномерной или трехмерной[2]

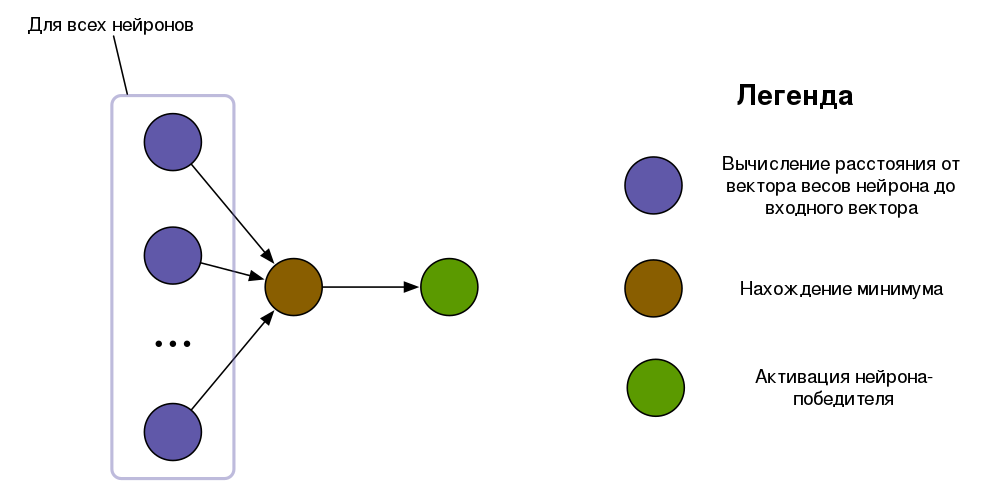

Для того, чтобы определить кластер, к которому принадлежит данный входной вектор, вектор подают во входной слой сети. Для каждого нейрона вычисляется расстояние между входным вектором и вектором весов. Нейрон с наименьшим расстоянием между вектором весов и входным вектором активируется, обозначая принадлежность входного вектора соответствующему кластеру. Таким образом, число кластеров определяется числом нейронов. Особенностью работы алгоритма является то, что близкие друг к другу входные векторы активируют нейроны, близкие друг к другу на сетке. Это свойство оказывается удобным для визуализации кластеризованных данных[3].

Процесс обучения сети состоит в «соревновании» между нейронами. На каждом шаге случайным образом выбирается один из входных векторов. Из всех нейронов выбирается нейрон-победитель, который имеет наименьшее расстояние между вектором весов и входным вектором. Векторы весов всех нейронов, находящихся в пределах радиуса обучения от нейрона-победителя, сдвигаются в сторону входного вектора Вектор весов этого нейрона сдвигается в сторону входного вектора. Также в сторону входного вектора сдвигаются векторы весов остальных нейронов, причем степень сдвига зависит от расстояния до нейрона-победителя на сетке. В результате этого процесса векторы весов нейронов распределяются по пространству входных векторов.

1.2 Математическое описание алгоритма

Ниже описаны используемые обозначения, а также формулы, по которым производится счет алгоритма. Далее приведены шаги алгоритма обучения сети и шаги алгоритма использования сети.

1.2.1 Обозначения и формулы

Входные данные: набор вещественных векторов x_1, x_2, ..., x_N, x_i \in R^m, N — число входных векторов

Текущее время: t

Входной вектор, выбранный случайным образом в момент времени t: x^{t}

Число нейронов: n

Размерность сетки нейронов: D. Как упоминалось выше, всюду в данной статье считаем сетку двумерной, т.е. D = 2

Размер двумерной сетки нейронов: k

Веса нейронов: набор векторов w_{1}^{t}, w_{2}^{t}, ..., w_{n}^{t}, где w_{j}^{t} принадлежит R^m, n — число нейронов, t — текущее время

Нейрон-победитель: его номер определяется формулой c = arg \min_{j} \parallel x^{t} - w_{j}^{t} \parallel

Функция скорости обучения сети: a\left(t\right) = a_0 \cdot exp\left\{-\frac{t}{\lambda_{1}}\right\}, где a_0, \lambda_{1} — настраиваемые параметры. Возможно использование других функций.

Радиус нейрона-победителя: \sigma\left(t\right) = \sigma_0 \cdot exp\left\{-\frac{t}{\lambda_{2}}\right\}, где \sigma_0, \lambda_{2} — настраиваемые параметры.

Функция расстояния между нейроном-победителем и другим нейроном: h\left(d_{cj}, t\right) = exp\left\{-\frac{d_{cj}^2}{2 \cdot \sigma^2\left(t\right)}\right\}, где d_{cj} — расстояние между нейроном-победителем и другим нейроном на сетке.

Функция соседства нейрона j: h_{j}\left(t\right) = h\left(d_{cj}, t\right) \cdot a\left(t\right), где h\left(d_{cj}, t\right) — функция расстояния между нейроном j и нейроном-победителем.

Данные, вычисляемые при обучении сети: веса нейронов в момент времени t + 1, вычисляемые по формуле w_{j}^{t + 1} = w_{j}^{t} + h_j(t) \cdot \left[x^{t} - w_{j}^{t}\right], где x^{t} — случайным образом выбранный входной вектор, w_{j}^{t} — вектор весов нейрона j в момент времени t, h_{j}\left(t\right) — функция соседства нейрона j

Данные, вычисляемые при использовании сети: номер нейрона-победителя c

1.2.2 Шаги обучения сети

- Проинициализировать время: t = 0 и выбрать максимальное время t_{max}

- Проинициализировать векторы весов нейронов случайным образом

- Случайным образом выбрать входной вектор x^{t}

- Вычислить расстояния от векторов весов нейронов до входного вектора

- Найти номер c нейрона-победителя, у которого расстояние от вектора весов до входного вектора минимально

- Вычислить радиус обучения \sigma\left(t\right)

- Вычислить расстояния на сетке от нейрона-победителя до остальных нейронов

- Для всех нейронов, находящихся в пределах радиуса обучения от нейрона-победителя, вычислить новые векторы весов

- Увеличить время: t = t + 1

- Если текущее время t равно максимальному t_{max}, то алгоритм завершается. Иначе перейти на шаг 3.

1.2.3 Шаги использования сети

- Вычислить расстояния от векторов весов нейронов до входного вектора

- Активировать нейрон с минимальным расстоянием

1.3 Вычислительное ядро алгоритма

Алгоритм имеет два вычислительных ядра — нахождение нейрона-победителя и пересчет векторов весов нейронов. Вычисление этих ядер повторяется друг за другом при обучении сети. При использовании сети выполняется только нахождение нейрона-победителя, при этом нейрон-победитель активируется и обозначает кластер, к которому принадлежит входной вектор.

Для нахождения нейрона-победителя вычисляются расстояния между векторами весов нейронов и входным вектором. Нейрон с минимальным расстоянием выбирается в качестве нейрона-победителя.

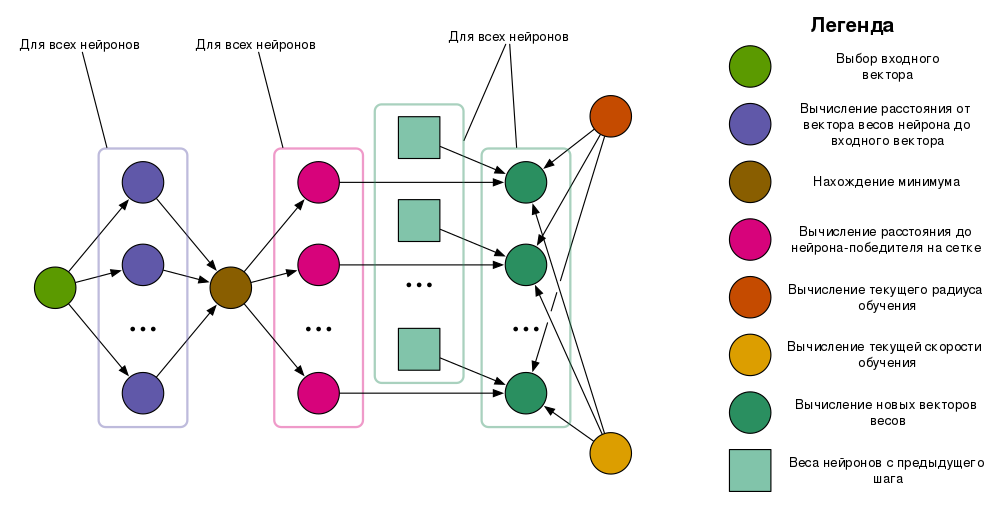

Для пересчета векторов весов нейронов вычисляется текущий радиус обучения, затем вычисляются расстояния на сетке между нейроном-победителем и остальными нейронами. Векторы весов нейронов, вошедших в радиус обучения, пересчитываются в соответствии с формулами.

1.4 Макроструктура алгоритма

Можно выделить следующие макрооперации:

- Выбор входного вектора

- Вычисление расстояний между векторами весов нейронов и входным вектором

- Нахождение минимального расстояния

- Нахождение радиуса обучения

- Нахождение текущей скорости обучения

- Вычисление расстояний между нейронами на сетке

- Пересчет векторов весов

Процесс обучения сети состоит из повторяющихся друг за другом операций пересчета векторов весов нейронов. На каждой итерации для этого производится выбор входного вектора, нахождение нейрона-победителя, и наконец, пересчет векторов весов. Новые векторы весов нейронов используются для пересчета на следующей итерации.

Процесс использования сети включает в себя лишь поиск нейрона-победителя, который затем активируется.

1.5 Схема реализации последовательного алгоритма

1.5.1 Последовательность выполнения обучения сети

- Выбрать параметры a_0, \lambda_{1}, \sigma_0, \lambda_{2}, t_{max}

- t = 0

До тех пор, пока t \neq t_{max}, выполняются следующие шаги:

- Случайным образом выбрать входной вектор x^{t}

- \forall j \in \left\{0, \ldots, n\right\} вычислить d_{j}^{t} = \parallel x^{t} - w_{j}^{t} \parallel — расстояние между вектором весов нейрона j и входным вектором

- Найти c = arg \min_{j} d_{j}^{t}

- Вычислить текущий радиус обучения \sigma\left(t\right) = \sigma_0 \cdot exp\left\{-\frac{t}{\lambda_{2}}\right\}

- Вычислить текущую скорость обучения a\left(t\right) = a_0 \cdot exp\left\{-\frac{t}{\lambda_{1}}\right\}

- \forall j \in \left\{0, \ldots, n\right\} \setminus \left\{c\right\} вычислить расстояние от нейрона j до нейрона-победителя: d_{cj}.

- \forall j: d_{c,j} \lt \sigma\left(t\right) посчитать новый вес нейрона j: w_{j}^{t + 1} = w_{j}^{t} + exp\left\{-\frac{d_{cj}^2}{2 \cdot \sigma^2\left(t\right)}\right\} \cdot a\left(t\right) \cdot \left[x^{t} - w_{j}^{t}\right]

- t = t + 1

1.5.2 Последовательность выполнения использования сети

- \forall j \in \left\{0, \ldots, n\right\} вычислить d_{j} = \parallel x - w_{j} \parallel — расстояние между вектором весов нейрона j и входным вектором

- Найти c = arg \min_{j} d_{j}

- Активировать нейрон c

1.6 Последовательная сложность алгоритма

1.6.1 Алгоритм обучения сети

1.6.1.1 В терминах макроопераций

Число операций выбора входного вектора: t_{max}

Число операций вычисления расстояний между векторами весов нейронов и входным вектором: t_{max} \cdot n

Число операций нахождения минимального расстояния: t_{max}

Число операций нахождения радиуса обучения: t_{max}

Число операций нахождения текущей скорости обучения: t_{max}

Число операций вычисления расстояний между нейронами на сетке: t_{max} \cdot (n - 1)

Число операций пересчета векторов весов нейронов: t_{max} \cdot n

1.6.1.2 В терминах низкоуровневых операций

Число сложений и вычитаний: t_{max} \cdot \left(n \cdot \left(4m - 1\right) + \left(n - 1\right) \cdot \left(2D - 1\right)\right)

Число умножений: t_{max} \cdot \left( n \cdot \left(2m + 4\right) + \left(n - 1\right) \cdot D + 2\right)

Число делений: t_{max} \cdot \left(n + 2\right)

Число вычислений квадратного корня: t_{max} \cdot \left(2n -1\right)

Число вычислений экспоненты: t_{max} \cdot \left(n + 2\right)

1.6.2 Алгоритм использования сети

1.6.2.1 В терминах макроопераций

Число операций вычисления расстояний между векторами весов нейронов и входным вектором: n

Число операций нахождения минимального расстояния: 1

1.6.2.2 В терминах низкоуровневых операций

Число умножений: n \cdot m

Число сложений и вычитаний: n \cdot (2m - 1)

Число вычислений квадратного корня: n

1.7 Информационный граф

Опишем вершины, входящие в информационный граф[4][5], соответствующие им операции, а также входные и выходные данные.

Выбор входного вектора — вершинам данного типа соответствует операция выбора входного вектора. Входные данные отсутствуют, выходом является случайным образом выбранный входной вектор.

Вычисление расстояния от вектора весов нейрона до входного вектора — входными данными операции являются вектор весов нейрона и входной вектор. Выходом операции является евклидово расстояние между вектором весов и входным вектором.

Нахождение минимума — на входе операции набор расстояний, на выходе — номер наименьшего расстояния

Вычисление расстояния до нейрона-победителя на сетке — на входе номер нейрона-победителя и номер нейрона, на выходе — расстояние на сетке между нейроном-победителем и нейроном

Вычисление текущего радиуса обучения — на входе текущее время и заранее заданные параметры радиуса обучения, на выходе — текущий радиус обучения

Вычисление текущей скорости обучения — на входе текущее время и заранее заданные параметры скорости обучения, на выходе — текущая скорость обучения.

Вычисление новых векторов весов — на входе расстояние на сетке между нейроном и нейроном-победителем, вектор весов нейрона, текущий радиус обучения и текущая скорость обучения. На выходе операции новый вектор весов нейрона. Новый вектор весов может совпадать со старым, например, в случае, когда нейрон не входит в радиус обучения нейрона-победителя.

Активация нейрона-победителя — на входе номер нейрона.

Для ясности наличие некоторых параметров у операций не отражено на изображении информационного графа.

1.8 Ресурс параллелизма алгоритма

1.8.1 Алгоритм обучения сети

Для обучения сети требуется t_{max} раз последовательно выполнить следующие ярусы:

- Выбор входного вектора (ширина 1)

- Вычисление расстояний от векторов весов нейронов до входного вектора (ширина n)

- Нахождение минимума (ширина 1)

- Вычисление расстояния до нейрона-победителя на сетке (ширина n)

- Вычисление новых векторов весов (ширина n)

Операции вычисления текущего радиуса обучения и текущей скорости обучения могут как представлять собой два отдельных радиуса шириной 1, так и входить в ярус вычисления новых векторов весов.

Наличие двух ярусов шириной 1 является проблемой, так как во время вычисления этих ярусов большая часть ресурсов будет простаивать.

Рассматривая ширину и высоту ярусно-параллельной формы, находим, что ширина равна n, а высота равна 5 \cdot t_{max}. Таким образом, сложность параллельной реализации алгоритма обучения составляет O\left(t_{max}\right).

1.8.2 Алгоритм использования сети

Для использования сети требуется последовательно выполнить следующие ярусы:

- Вычисление расстояний от векторов весов нейронов до входного вектора (ширина n)

- Нахождение минимума (ширина 1)

- Активация нейрона (ширина 1)

Ширина ярусно-параллельной формы графа алгоритма равна n, а высота равна 3. Таким образом, сложность параллельной реализации алгоритма составляет O\left(1\right)

1.9 Входные и выходные данные алгоритма

1.9.1 Алгоритм обучения сети

Входные данные: набор вещественных векторов x_1, x_2, ..., x_N, x_i \in R^m, N — число входных векторов

Объем входных данных: N \cdot m

Выходные данные: набор векторов весов нейронов w_{1}, w_{2}, ..., w_{n}, w_{j} \in R^m, где n — число нейронов

Объем выходных данных: n \cdot m

1.9.2 Алгоритм использования сети

Входные данные: Входной вектор x \in R^m

Объем входных данных: \cdot m

Выходные данные: номер активированного нейрона c

Объем выходных данных: 1

1.10 Свойства алгоритма

Суммарный объем входных и выходных данных алгоритма составляет \left(N + n\right) \cdot m. Вооружившись этим фактом и подсчитав число макроопераций алгоритма, получим, что вычислительная мощность алгоритма обучения сети имеет вид \frac{3 t_{max} \left(n + 1\right)}{\left(N + n\right) m} и линейно зависит от t_{max}. Вычислительная мощность алгоритма использования сети имеет вид \frac{n + 1}{m + 1}.

Недостатком алгоритма является то, что число кластеров необходимо задавать заранее, задавая число нейронов. Кроме того, имеет значение конфигурация сетки — ее размерность и размеры.

Алгоритм не подходит для дискретных или категорических данных, кроме того, он не подходит для использования с неполными данными.

Алгоритм обучения сети является недетерминированным, так как, во-первых, на каждом шаге необходимо случайным образом выбирать входной вектор, во-вторых, результат работы зависит от инициализации векторов весов нейронов.

2 Программная реализация алгоритма

2.1 Особенности реализации последовательного алгоритма

2.2 Локальность данных и вычислений

2.3 Возможные способы и особенности параллельной реализации алгоритма

2.4 Масштабируемость алгоритма и его реализации

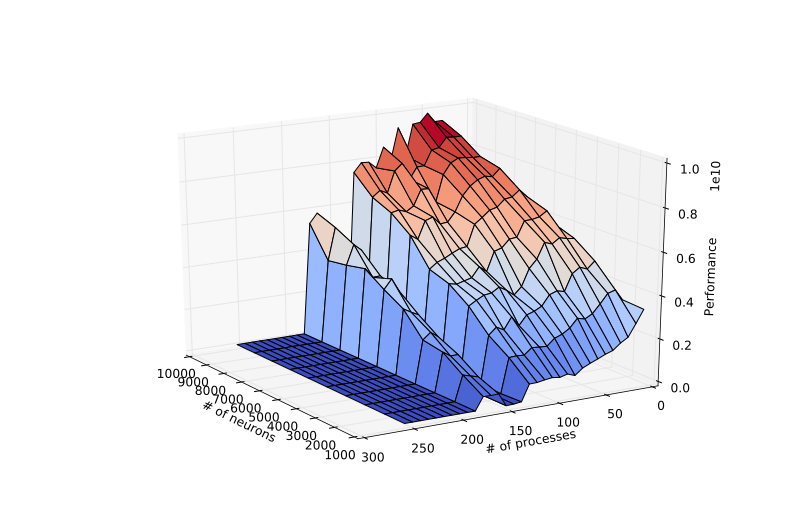

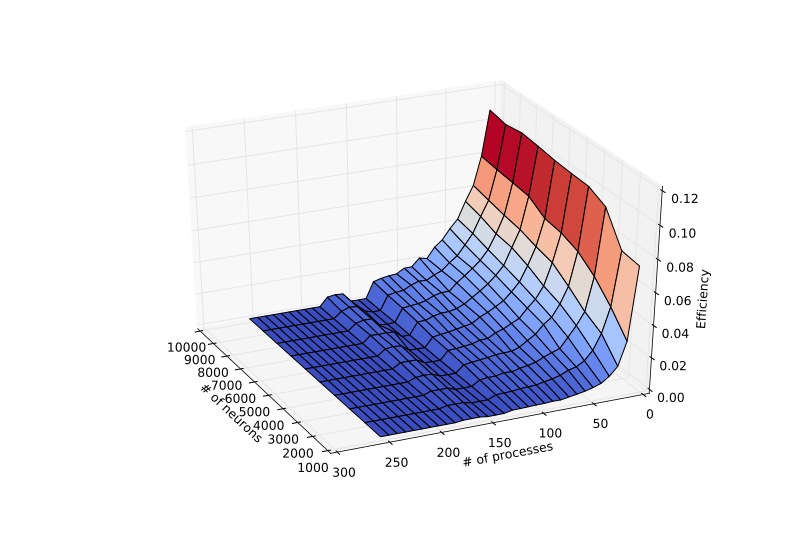

Было решено исследовать масштабируемость алгоритма обучения сети, так как он является более вычислительно сложным, чем алгоритм использования сети. Алгоритм использования сети, в свою очередь, по сути выполняет лишь некоторую часть того, что алгоритм обучения делает на каждой итерации, и поэтому менее интересен для исследования. Все эксперименты выполнялись на суперкомпьютере "Ломоносов".

2.4.1 Описание реализации

Для исследования масштабируемости реализации алгоритма была написана реализация на языке C с использованием MPI. Кратко можно описать работу реализации следующим образом — каждый процесс получает определенный диапазон нейронов. Процессы инициализируют веса своих нейронов случайным образом. Чтобы избежать повторения весов при инициализации, каждый процесс инициализирует генератор псевдослучайных чисел числом, зависящим от номера процесса. Один из процессов играет роль главного процесса. На каждой итерации он случайным образом выбирает один входной вектор и с помощью широковещательной рассылки передает его другим процессам. Каждый процесс ищет в своем диапазоне нейронов тот нейрон, вектор весов которого ближе всего к входному вектору, и передает расстояние и номер нейрона главному процессу. Главный процесс на основе этой информации выбирает ближайший к входному вектору нейрон и передает его номер всем остальным. Затем каждый процесс независимо от остальных пересчитывает веса своих нейронов и переходит к следующей итерации. После того, как все итерации выполнены, все процессы передают главному процессу веса нейронов, которые тот объединяет в одном массиве и записывает в выходной файл.

Реализацию можно найти в репозитории. Там же в файле README.md описан формат входных и выходных данных алгоритма обучения сети, доступные опции, а также описано, как нужно собирать и запускать программу на суперкомпьютере "Ломоносов".

2.4.2 Входные данные

В качестве входных данных использовался сгенерированный набор трехмерных векторов, представляющих собой цвета в пространстве RGB. Каждый цвет представлял собой сумму базового цвета (красный, голубой или зеленый) и нормального шума. Таким образом, все цвета группировались в три кластера вокруг трех базовых цветов. Всего в наборе было 3000 векторов, по 1000 на каждый базовый цвет. Такой набор был выбран по той причине, что результат работы алгоритма удобно визуализировать и оценить корректность результата.

2.4.3 Произведенные измерения

Для того, чтобы измерить время выполнения параллельной реализации, использовался следующий подход — в начале выполнения программы процессы синхронизируются, и сразу после этого главный процесс засекает время. После того, как программа выполнена и главный процесс запишет веса нейронов в выходной файл, снова выполняется синхронизация, после чего главный процесс снова засекает время, вычисляет время выполнения и записывает его в стандартный поток вывода.

Чтобы измерить производительность реализации алгоритма, необходимо измерять число операций с плавающей точкой. Для этого в программе использовался счетчик, который инкрементировался при выполнении операторов языка Си, задействующих вычисления с плавающей точкой. Для сложных библиотечных функций, таких, как экспонента, вычисление квадратного корня, вычисление степени числа, была проведена оценка числа операций с плавающей точкой, которые они включают. Для этого были написаны тестовые программы, которые выполняют эти операции. Тестовые программы были скомпилированы на Ломоносове, затем с помощью программы perf замерялось число операций с плавающей точкой. Полученные оценки прибавлялись к счетчику при выполнении этих библиотечных функций.

Для оценки эффективности с сайта Intel была получена информация о производительности процессоров серии Xeon 5500. Далее для эксперимента c P процессами пиковая производительность оценивалась как производительность одного процессора Xeon, поделенная на число ядер процессора (8 ядер) и умноженная на число процессов P. Затем эффективность подсчитывалась как отношение реально достигнутой производительности и пиковой производительности.

2.4.4 Проведенные эксперименты

Были проведены эксперименты, в которых обучалась сеть с различным числом нейронов. Для удобства запуска использовалась одномерная сетка размером 1 \times N. Число нейронов N менялось в пределах от 1000 до 10000 включительно с шагом в 1000 нейронов. Число процессов менялось в пределах от 8 до 256 процессов с шагом в 8 процессов. В каждом эксперименте число итераций было одинаковым и было равно 10000.

Для компиляции реализации использовался компилятор, входящий в состав OpenMPI. Использовалась версия OpenMPI 1.8.4 (на суперкомпьютере может быть подключена командой module load openmpi/1.8.4-gcc).

Полный список опций компиляции:

-O2 -Wall -Werror -Wformat-security -Wignored-qualifiers -Winit-self -Wswitch-default -Wfloat-equal -Wpointer-arith -Wtype-limits -Wempty-body -Wstrict-prototypes -Wold-style-definition -Wmissing-field-initializers -Wnested-externs -Wno-pointer-sign -std=gnu99

Для компиляции нужно выполнить следующие команды (при условии, что файлы из репозитория скопированы в папку ~/_scratch):

cd ~/_scratch

module load openmpi/1.8.4-gcc

make kohonen_learn # Исполняемый файл kohonen_learn

Все эксперименты запускались на выполнение с помощью команды sbatch, входящей в состав планировщика нагрузки Slurm. Эксперименты с числом процессов меньше или равным 128, проводились в очреди test, так как нагрузка на нее меньше, и эксперименты можно провести быстрее. Остальные эксперименты проводились в очереди regular4.

Для автоматизации экспериментов был написан скрипт, который позволяет автоматически отправлять новые задачи на выполнение, как только представляется такая возможность. Его параметры можно менять с помощью переменных окружения. Таким образом, для воспроизведения результатов достаточно выполнить следующие команды (при условии, что программа уже скомпилирована):

cd ~/_scratch

module load openmpi/1.8.4-gcc # Нужно, чтобы можно было использовать скрипт запуска ompi

module load slurm/2.5.6

export queue=regular4

export neurons_start=1000

export neurons_step=1000

export neurons_max=10000

export num_procs=8

export num_procs_step=8

export num_procs_max=256

./submit_jobs_by_neurons.sh

Максимальная производительность алгоритма составила 9827675645.18 FLOP/s, то есть 9.82 GFLOP/s, и достигалась при числе нейронов 10000 и числе процессов 48. Минимальная производительность алгоритма составила 1748984.26 FLOP/s, то есть 1.74 MFLOP/s, и достигалась при числе нейронов 1000 и числе процессов 216.

Максимальная эффективность реализации алгоритма составила 10.6 % и достигалась при числе нейронов 10000 и числе процессов 8. Минимальная эффективность реализации алгоритма составила 0.00012 % и достигалась при числе нейронов 1000 и числе процессов 248.

Исследуя график эффективности реализации алгоритма, можем видеть, что при увеличении числа процессов эффективность быстро падает. При числе процессов 160, 168, 176 наблюдаем небольшой подъем эффективности, который лучше виден на графике производительности. Можно также видеть рост эффективности при увеличении числа нейронов, но он становится меньше с увеличением числа процессов.

2.5 Динамические характеристики и эффективность реализации алгоритма

2.6 Выводы для классов архитектур

2.7 Существующие реализации алгоритма

Существует реализация алгоритма, написанная на языке C автором алгоритма Теуво Кохоненом при поддержке других исследователей. Лицензия, под которой выпущен код, разрешает только использование в научных целях. Ссылка.

Другая реализация алгоритма написана на языке C++ и выпущена под лицензией BSD, разрещающей использование в коммерческих целях. Также эта реализация позволяет конфигурировать размеры сетки нейронов. Ссылка.

3 Литература

<references \>

- ↑ Kohonen, T. Biol. Cybern. (1982) 43: 59. doi:10.1007/BF00337288

- ↑ Rojas R. Neural Networks: A Systematic Introduction Springer-Verlag Berlin Heidelberg, 1996.

- ↑ Guthikonda, Shyam M. "Kohonen self-organizing maps." Wittenberg University (2005).

- ↑ Воеводин В.В. Математические основы параллельных вычислений// М.: Изд. Моск. ун-та, 1991. 345 с.

- ↑ Воеводин В.В., Воеводин Вл.В. Параллельные вычисления. – СПб.: БХВ - Петербург, 2002. – 608 с.