Участник:Demon smd/Нечеткий алгоритм С средних

| Эта работа прошла предварительную проверку Дата последней правки страницы: 19.12.2016 Данная работа соответствует формальным критериям. Проверено Coctic. |

| Нечеткий алгоритм C средних (Fuzzy C-means) | |

| Последовательный алгоритм | |

| Последовательная сложность | O(C^2*|X|*D*IterNumber) |

| Объём входных данных | |X|*p, где p - размерность входных векторов |

| Объём выходных данных | |X|*C |

| Параллельный алгоритм | |

| Высота ярусно-параллельной формы | O(\log_{2}C^4*|X|^3) * IterNumber |

| Ширина ярусно-параллельной формы | O(C^2*|X|) |

Авторы описания алгоритма:

Д.А.Гуськов

М.А.Абраменкова.

Во все разделы вклад равноценный.

Содержание

- 1 Свойства и структура алгоритма

- 1.1 Общее описание алгоритма

- 1.2 Математическое описание алгоритма

- 1.3 Вычислительное ядро алгоритма

- 1.4 Макроструктура алгоритма

- 1.5 Схема реализации последовательного алгоритма

- 1.6 Последовательная сложность алгоритма

- 1.7 Информационный граф

- 1.8 Ресурс параллелизма алгоритма

- 1.9 Входные и выходные данные алгоритма

- 1.10 Свойства алгоритма

- 2 Программная реализация алгоритма

- 2.1 Особенности реализации последовательного алгоритма

- 2.2 Локальность данных и вычислений

- 2.3 Возможные способы и особенности параллельной реализации алгоритма

- 2.4 Масштабируемость алгоритма и его реализации

- 2.5 Динамические характеристики и эффективность реализации алгоритма

- 2.6 Выводы для классов архитектур

- 2.7 Существующие реализации алгоритма

- 3 Литература

1 Свойства и структура алгоритма

1.1 Общее описание алгоритма

Нечёткий алгоритм кластеризации С-средних был разработан (для случая m=2) J.C. Dunn в 1973 г. [1] и усовершенствован (для случая m>1) J.C. Bezdek в 1981 г. [2] . В отличие от алгоритма c-means данный метод кластеризации предполагает, что входные данные могут принадлежать более, чем одному кластеру одновременно. Алгоритм получает на вход набор кластеризуемых векторов, количество кластеров, коэффициент неопределённости m и коэффициент \varepsilon \gt 0, определяющий точность алгоритма. На выходе алгоритма получаем матрицу вероятностей принадлежности каждого входного вектора каждому кластеру.

Нечеткий алгоритм С средних заключается в следующем. Изначально для каждого вектора определяется случайным образом вероятность принадлежности вектора к каждому кластеру. Далее запускается итерационный процесс, на каждой итерации которого происходит:

1) расчёт центров кластеров

2) расчёт Евклидова расстояния от каждого вектора до центра каждого кластера

3) расчёт и нормализация коэффициентов принадлежности векторов кластерам

4) расчёт значения решающей функции и сравнение этого значения со значением решающей функции на предшествующей итерации: если разница этих значений меньше установленного значения, то алгоритм прекращает работу (решающая функция возвращает сумму всех Евклидовых расстояний каждого объекта к каждому центру кластера умноженному на коэффициент принадлежности)

1.2 Математическое описание алгоритма

Нечеткий алгоритм С средних минимизирует величину:

- \begin{align} \sum_{i = 1}^{|X|}\sum_{j = 1}^{C}u_{i,j}^m\left\Vert{x_{i}-c_{j}}\right\|^2 & , & & 1 \le m \le \infty , \\ \end{align}

где m - это действительное число не меньше единицы, u_{i,j} - коэффициент принадлежности вектора x_{i} к кластеру c_{j}, x_{i} - i-ый компонент |X|-мерного вектора X, C - количество кластеров, c_{j} - центр j-ого кластера, а \left\Vert{*}\right\| - это любая норма, определяющая расстояние от вектора до центра кластера. Нечёткое разбиение входных данных на кластеры производится итеративной оптимизацией вышеуказанной функции с обновлением коэффициента принадлежности u_{i,j} и переопределением центра кластера c_{j} на каждой итерации алгоритма.

1.2.1 Вычисляемые данные на каждой итерации

- Центры кластеров рассчитываются по следующей формуле: c_{j} = {{\sum_{i = 1}^{n}{u_{i,j}^m} * x_{i}} \over {\sum_{i = 1}^{n}{u_{i,j}^m}}}, где u_{i,j} — коэффициент принадлежности x_{i} вектора к кластеру c_{j}.

- Коэффициент принадлежности рассчитывается по формуле: u_{i,j} = {1 \over \sum_{k = 1}^{C}{({\left\Vert{x_{i}-c_{j}}\right\| \over \left\Vert{x_{i}-c_{k}}\right\|})}^{2 \over m-1}}

- Решающая функция рассчитывается по формуле: \max_{i,j}(|u_{i,j}^{(k)} - u_{i,j}^{(k-1)}|), где k - номер итерации алгоритма

1.3 Вычислительное ядро алгоритма

Ядром алгоритма является:

- вычисление новых центров кластеров

- для каждого входного вектора вычисление Евклидова расстояния до центров кластеров, а также коэффициента принадлежности кластерам

- вычисление решающей функции

1.4 Макроструктура алгоритма

В каждой итерации алгоритма происходит 3 основных действия описанных в п. 1.2.1:

- вычисление центров кластеров

- вычисление коэффициентов принадлежности

- вычисление решающей функции

Подробное описание макроструктур в виде кода приведено в пункте 1.5

1.5 Схема реализации последовательного алгоритма

Схему реализации последовательного алгоритма можно описать на C++ следующим образом:

FCM (X[], C, m, eps){

float deside = 0;

float newDeside = 0;

generateMembershipDegree(); //заполняет uPrev[][] случайными нормрованными коэффициентами

while (true){

newDeside = deside;

//вычисление центров кластеров

for (int j=0; j<C; j++){ //для каждого кластера

float numerator = 0;

float denumerator = 0;

for (int i=0; i<X.size(); i++){ //для каждого вектора

numerator+=pow(u[i][j], m) * x[i];

denumerator+=pow(u[i][j], m);

}

c[j] = numerator / denumerator;

}

//вычисление коэффициентов u[][]

for (int i=0; i<X.size(); i++) //для каждого вектора

for (int j=0; j<C; j++){ //для каждого кластера

sum = 0;

for (int k=0; k<C; k++)

sum+= pow( dist(x[i], c[j]) / dist(x[i], c[k]), 2/(m-1));

u[i][j] = 1/sum

}

//определения максимального различия между u[][] и uPrev[][]

float max = 0;

for (int i=0; i<X.size(); i++) //для каждого вектора

for (int j=0; j<C; j++){ //для каждого кластера

if (abs(uPrev[i][j]-u[i][j])>max)

max = abs(uPrev[i][j]-u[i][j]);

if (eps <= max)

for (int i=0; i<X.size(); i++) //для каждого вектора

for (int j=0; j<C; j++){ //для каждого кластера

uPrev[i][j]=u[i][j];

else

break;

}

return u;

}

1.6 Последовательная сложность алгоритма

Последовательная сложность всего алгоритма складывается из сложности операций на каждой итерации умноженную на количество итераций. Под операцией будем понимать выражение в языке с++ из пункта 1.5, находящееся в теле цикла (например, выражения "sum+= pow( dist(x[i], c[j]) / dist(x[i], c[k]), 2/(m-1));" или "uPrev[i][j]=u[i][j];" считаются за одну операцию). Так как при больших входных объёмах данных сложность алгоритма в большей степени зависит от количества входных данных, и незначительно зависит от сложности операций,то при оценке сложности алгоритма сложность выражений можно считать равной единице. Так как в данном алгоритме количество итераций не является фиксированным и зависит от:

- параметра \varepsilon

- набора входных векторов x

- выбора начальных коэффициентов u

то в данном пункте будет приведена сложность одной итерации относительно количества входных векторов. Для вычисления коэффициентов u[][] на каждой итерации алгоритма требуется определить расстояние от векторов до центра кластера. Сложность данной операции зависит от размерности входных данных и определении нормы. В виду того, что для разных задач могут быть введены разные нормы, и сложность вычисления расстояний может варьироваться, то в данной статье будем считать, что сложность вычисления расстояния зависит линейно от размерности водных данных. В таком случае, для вычисления центров кластеров требуется O(2*C*|X|) операций, для определения коэффициентов u - O(C^2*|X|*D) операций, а для вычисления решающей функции - O(2*C*|X|) операций, где |X| - число входных векторов, а C - количество кластеров.

Таким образом итоговая сложность одной итерации составляет O(C^2*|X|*D).

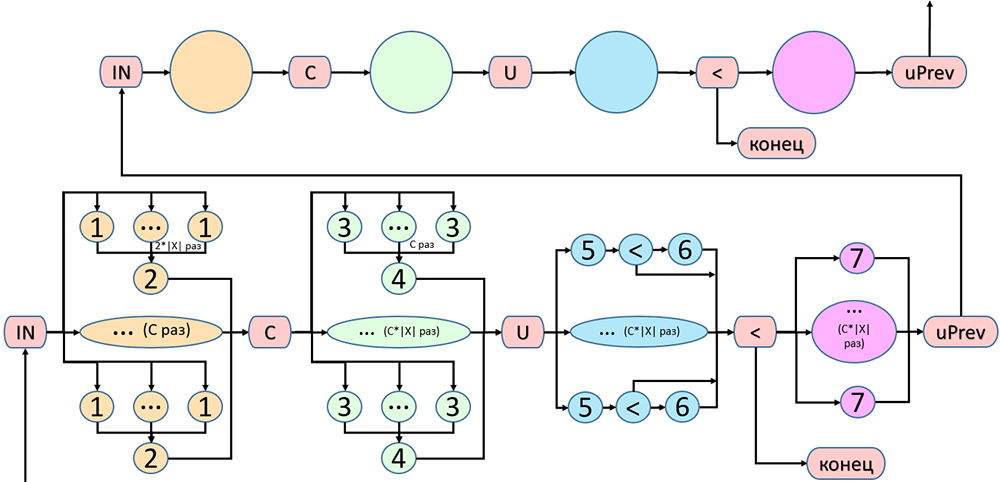

1.7 Информационный граф

Как видно из пункта 1.5, на каждом действии каждой итерации алгоритма все операции, выполняющиеся в цикле, не зависят друг от друга и могут быть распараллелены. Это показано на Рисунке 1.

1.8 Ресурс параллелизма алгоритма

На каждом ярусе ярусно-параллельной формы алгоритма будет располагаться конечное число элементарных операций, например, чтение элемента из памяти, сложение или возведение в степень. Информационый граф из п.1.7 изображает свёрнутую ярусно-параллельную форму алгоритма.

Сложность алгоритма будем рассчитывать в предположении, что число вычислительных ядер стремится к бесконечности. Как видно из информационного графа, параллельная сложность вычисления центров кластеров составляет O(\log_{2}(C*|X|)), вычисления коэффициентов принадлежности - O(\log_{2}(C^2*|X|)), а вычисления решающей функции - не больше чем O(\log_{2} (C*|X|)).

Таким образом параллельная сложность итерации алгоритма составляет O(\log_{2} (C^4*|X|^3)).

Так как задачи, решаемые в макроструктуре алгоритма могут быть сведены к задачам вычисления суммы элементов массива и максимального элемента массива, то на i-ом ярусе графа будет находиться {N}\over{2^i} операции, где N - количество элементов массива.

1.9 Входные и выходные данные алгоритма

1.9.1 Входные данные алгоритма

- X - набор из |X| входных векторов длины p

- C - количество кластеров

- m - коэффициент неопределённости

- \varepsilon \gt 0 - коэффициент, определяющий точность алгоритма.

Объем входных данных: |X|*p+3

1.9.2 Выходные данные алгоритма

- u - матрица принадлежности векторов кластерам

Объем выходных данных: |X|*C

1.10 Свойства алгоритма

Увеличение скорости работы алгоритма при распараллеливании на бесконечном количестве процессоров составляет O({{C^2*|X|}\over{\log_{2} (C^4*|X|^3)}}). Например, для разбиения 1000 элементов на 10 кластеров производительность параллельного алгоритма будет в 2315 раз больше, а на 20 кластеров - уже в 8477 раз.

2 Программная реализация алгоритма

2.1 Особенности реализации последовательного алгоритма

2.2 Локальность данных и вычислений

2.3 Возможные способы и особенности параллельной реализации алгоритма

2.4 Масштабируемость алгоритма и его реализации

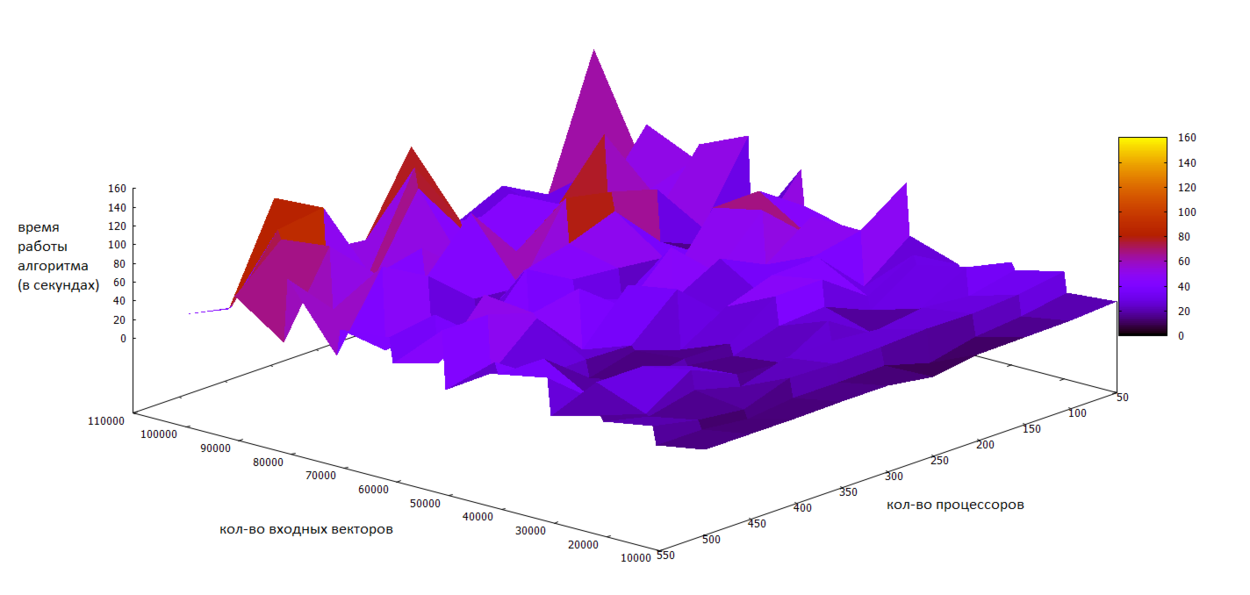

Как видно из предыдущих пунктов, масштабируется данный алгоритм хорошо. С увеличением количества процессоров время работы падает, а с увеличением количества входных данных и количества кластеров - растёт. На рисунках показаны результаты запусков алгоритма на разном количестве входных данных и процессоров на массивно-параллельной вычислительной системе Blue Gene/P. Использовался компилятор mpixlcxx без указания специфических опций. Запуски производились в режиме SMP (на каждом ядре 1 MPI процесс из 4 SMP нитей, 2 Гб памяти). Характеристики вычислительного узла: 4 ядерный 32-битный процессор PowerPC 850 Мгц.

Исходных код программы можно найти здесь: https://github.com/demonsmd/superPrak

2.5 Динамические характеристики и эффективность реализации алгоритма

2.6 Выводы для классов архитектур

2.7 Существующие реализации алгоритма

Существует множество реализаций данного алгоритма. Рассмотрим некоторые из них:

- Например, тут: https://habrahabr.ru/post/208496/ [3] приведено краткое описание алгоритма и приведена его реализация на php. В данной статье довольно подробно расписан каждый шаг алгоритма и приведён соответствующий ему фрагмент кода.

- Тут: http://num-meth.srcc.msu.ru/zhurnal/tom_2012/v13r207.html [4] приводится реализация алгоритма для PostgreSQL, а также прилагается скрипт внедрения алгоритма.

3 Литература

<references \>

- ↑ Dunn, J. C. (1973-01-01). "A Fuzzy Relative of the ISODATA Process and Its Use in Detecting Compact Well-Separated Clusters". Journal of Cybernetics. 3 (3): 32–57. doi:10.1080/01969727308546046. ISSN 0022-0280.

- ↑ Bezdek, James C. (1981). Pattern Recognition with Fuzzy Objective Function Algorithms. ISBN 0-306-40671-3.

- ↑ Нестер А. "Алгоритм нечёткой кластеризации fuzzy c-means на PHP". [html](https://habrahabr.ru/post/208496/)

- ↑ Миниахметов Р.М., Цымблер М.Л. "Интеграция алгоритма кластеризации Fuzzy c-Means в PostgreSQL". [html](http://num-meth.srcc.msu.ru/zhurnal/tom_2012/v13r207.html)