Участник:Stanis-morozov/Алгоритм Тренча вычисления спектра симметрической теплицевой матрицы

Алгоритм Тренча вычисления спектра симметрической теплицевой матрицы. Автор описания: С.В. Морозов.

Задача нахождения собственных значений и собственных векторов для матрицы A заключается в поиске таких соответствующих друг другу чисел \lambda и ненулевых векторов x, которые удовлетворяют уравнению Ax=\lambda x. Числа \lambda называются собственными значениями, а вектора x - соответствующими им собственными векторами.[1]

Теплицевой матрицей называется матрица, в которой на всех диагоналях, параллельных главной, стоят равные элементы.[2]

Содержание

- 1 Свойства и структура алгоритма

- 1.1 Общее описание алгоритма

- 1.2 Математическое описание алгоритма

- 1.3 Вычислительное ядро алгоритма

- 1.4 Макроструктура алгоритма

- 1.5 Схема реализации последовательного алгоритма

- 1.6 Последовательная сложность алгоритма

- 1.7 Информационный граф

- 1.8 Ресурс параллелизма алгоритма

- 1.9 Входные и выходные данные алгоритма

- 1.10 Свойства алгоритма

- 2 Программная реализация алгоритма

- 2.1 Особенности реализации последовательного алгоритма

- 2.2 Локальность данных и вычислений

- 2.3 Возможные способы и особенности параллельной реализации алгоритма

- 2.4 Масштабируемость алгоритма и его реализации

- 2.5 Динамические характеристики и эффективность реализации алгоритма

- 2.6 Выводы для классов архитектур

- 2.7 Существующие реализации алгоритма

- 3 Литература

1 Свойства и структура алгоритма

1.1 Общее описание алгоритма

Задача эффективного вычисления собственных значений матриц является одной из основных задач линейной алгебры. Известно, что собственные значения произвольной матрицы невозможно вычислить за конечное число операций, однако существует множество итерационных методов, позволяющих решать эту задачу, например, QR-алгоритм. Однако, для некоторых специальных классов матриц можно предложить более эффективные методы, чем QR-алгоритм. Так, в 1989 была опубликована работа В. Тренча [3], в которой был предложен метод вычисления собственных значений симметрической теплицевой матрицы, учитывающий особенности структуры таких матриц, и допускающий эффективную параллельную реализацию [4][5][6].

1.2 Математическое описание алгоритма

Пусть имеется матрица T_{n} порядка n\times n следующего вида:

- T_{n} = \begin{bmatrix} t_{0} & t_{1} & t_{2} & \cdots & t_{n-2} & t_{n-1} \\ t_{1} & t_{0} & t_{1}& \cdots & t_{n-3} & t_{n-2} \\ t_{2} & t_{1} & t_{0} & \cdots & t_{n-4} & t_{n-3} \\ \vdots & \vdots & \ddots & \ddots & \ddots & \vdots \\ t_{n-2} & \cdots & \cdots & t_{1} & t_{0} & t_{1} \\ t_{n-1} & \cdots & \cdots & t_{2} & t_{1} & t_{0} \\ \end{bmatrix}

Требуется найти ее собственные значения. Будем также предполагать, что ни одно из собственных значений T_{n} не является собственным значением для T_{1}, \dots, T_{n-1}. Однако, практические эксперименты, проведенные во многих работах, показывают, что данное ограничение существенно только в теории и не дает о себе знать в практических вычислениях.

Введем следующие обозначения. Обозначим

- p_{m}(\lambda) = det[T_{m} - \lambda I_{m}]

- q_{m}(\lambda) = p_{m}(\lambda) / p_{m-1}(\lambda)

Метод Тренча состоит в нахождении корней рациональной функции q_{n}(\lambda). При сделанных предположениях относительно матрицы T_{n}, эта задача равносильна задаче нахождения собственных значений матрицы T_{n}.

Обозначим также v_{m} = \begin{bmatrix} t_{1} \\ t_{2} \\ \vdots \\ t_{m} \\ \end{bmatrix}

Можно доказать, что если \lambda не является собственным значением T_{n}, а z_{m}(\lambda) является решением

- (T_{m} - \lambda I_{m})z_{m}(\lambda) = v_{m},

то

- q_{m}(\lambda) = t_{0} - \lambda - v_{m-1}^{T} z_{m-1}(\lambda).

Для решения системы можно использовать следующий модифицированный алгоритм Левинсона-Дурбина, эквивалентный в данном случае построению LDL^{T} разложения для матрицы T_{m} - \lambda I_{m}. Вычисления алгоритма проходят по следующим формулам:

- q_{1}(\lambda) = t_{0} - \lambda \\ z_{1,1}(\lambda) = t_{1} / q_{1}(\lambda) \\ q_{m}(\lambda) = (1 - z_{m-1, m-1}^2(\lambda)) q_{m-1}(\lambda) \\ z_{m,m}(\lambda) = q_{m}^{-1}(\lambda)\big(t_{m} - \sum\limits_{j=1}^{m-1} t_{m-j}z_{j,m-1}(\lambda)\big) \\ z_{j,m}(\lambda) = z_{j,m-1}(\lambda) - z_{m,m}(\lambda)z_{m-j,m-1}(\lambda), 1 \le j \le m-1

С другой стороны, заметив, что на диагонали матрицы D в полученном LDL^{T} разложении стоят значения q_{j}(\lambda), и применяя закон инерции квадратичных форм получаем, что количество элементов q_{j}(\lambda) меньших нуля, в точности равно количеству собственных значений матрицы T_n, меньших \lambda.

Кроме того, приведем важный для эффективного вычисления результат:

Теорема. Предположим, что \alpha и \beta не являются собственными значениями ни для какой из матриц T_{1}, \dots, T_{n}, и что (\alpha, \beta) содержит в точности одно собственное значение T_{n} кратности единица. Тогда (\alpha, \beta) не содержит собственных значений матрицы T_{n-1} тогда и только тогда, когда q_{n}(\alpha) \gt 0 и q_{n}(\beta) \lt 0.

Отсюда вытекает следующий алгоритм нахождения j-го по величине собственного значения матрицы T_{n}.

1. Находим отрезок, внутри которого лежат все собственные значения матрицы. Например, его можно найти с помощью кругов Гершгорина.

2. Локализуем j-ое собственное значение. Для этого используем метод деления отрезка пополам. Обозначим neg_{n}(\lambda) количество собственных значений T_{n} меньших \lambda. Имея процедуру вычисления neg_{n}(\lambda) и q_{n}(\lambda) легко построить алгоритм, сходящийся к \alpha и \beta, таким что

neg_{n}(\alpha) = j - 1 и neg_{n}(\beta) = j

q_{n}(\alpha) \gt 0 и q_{n}(\beta) \lt 0

3. Тогда на этом интервале функция q_{n}(\lambda) будет непрерывна (и более того, бесконечно дифференцируема) и можно применять другие, более эффективные методы нахождения корня уравнения.

1.3 Вычислительное ядро алгоритма

В алгоритме два основных вычислительных ядра. Первое состоит в локализации всех собственных значений, т.е. нахождении для каждого собственного значения матрицы \lambda_j такого отрезка (a, b), что он содержит в себе \lambda_j и не содержит других собственных значений матрицы, а также собственных значений матрицы меньшей размерности.

Второе состоит в приближении локализованного на интервале собственного значения с заданной точностью.

1.4 Макроструктура алгоритма

Введем базовые макрооперации, необходимые для описания алгоритма. Одна из базовых операций в алгоритме - это нахождение интервала, содержащего все собственные значения матрицы с помощью кругов Гершгорина. На псевдокоде эта задача может быть реализована следующим образом (за tj обозначен элемент теплицевой матрицы tkl для которого k - l = j):

mx = 0

for i = 1, n:

s1 = s2 = 0

for j = 2, i:

s1 += |tj|

for j = 2, n - i:

s2 += |tj|

mx = max(mx, s1 + s2)

a = t0 - mx

b = t0 + mx

Еще одна базовая макрооперация - это вычисление величин neg_n(\lambda) и q_n(\lambda) происходит одновременно по следующим формулам:

q1(λ) = t0 - λ

z1,1(λ) = t1 / q1(λ)

qm(λ) = (1 - z2m-1, m-1(λ)) qm-1(λ)

tmp = 0

for j = 1, m - 1:

tmp += tm-jzj,m-1(λ)

zm,m(λ) = q-1m(λ)(tm - tmp)

for j = 1, m:

zj,m(λ) = zj,m-1(λ) - zm,m(λ)zm-j,m-1(λ)

negn(λ) = 0

for j = 1, n:

if qj(λ) < 0:

negn(λ) += 1

Теперь, опишем операцию локализации собственного значения. Пусть имеется интервал (a, b). Будем дробить его пополам, и с помощью величины neg_n((a+b) / 2) находить количество собственных значений на каждом из получившихся интервалов. Как утверждает теорема, сформулированная выше, рано или поздно такое дробление приведет нас к интервалам, на которых выполняются следующие неравенства: neg_n(a) = j - 1, neg_n(b) = j, q_n(a) \gt 0, q_n(b) \lt 0. На этом локализация заканчивается. Более детальное описание алгоритма локализации приведено в следующем разделе.

Кроме этого, в алгоритме присутствует операция уточнения собственного значения. Она состоит в последовательном дроблении локализованного интервала, с последующей проверкой с помощью neg_n(\lambda) в какой из частей лежит собственное значения. Интервал сжимается до достижения требуемой точности.

Тогда, с помощью введенных макроопераций, алгоритм будет выглядеть следующим образом:

- С помощью кругов Гершгорина находим интервал, на котором содержатся все собственные значения

- Локализуем все собственные значения

- Уточняем все локализованные собственные значения

1.5 Схема реализации последовательного алгоритма

- Находим с помощью кругов Гершгорина интервал (a, b) на котором содержатся все собственные значения матрицы. Во избежание проблем с точным попаданием в собственные значения к a и b можно добавить случайные возмущения, расширяющие интервал.

- Инициализируем очередь интервалов интервалом (a, b, 1, n), где a и b обозначают границы интервалов, а 1 и n номера собственных значений, которые на нем находятся.

- Извлекаем интервал (l, r, p, q) из очереди

- Если p \ne q, переходим к шагу 6

- Вычисляем пары (neg_n(l), q_n(l)) и (neg_n(r), q_n(r)). Если neg_n(l) = p - 1, neg_n(r) = p, q_n(l) \gt 0 и q_n(r) \lt 0, то добавляем интервал (l, r, p) в список локализованных интервалов и переходим к шагу 3

- Вычисляем \lambda = (l + r) / 2 и neg_n(\lambda)

- Если neg_n(\lambda) \le p - 1, то добавляем интервал (\lambda, r, p, q) в очередь и переходим к шагу 3

- Если neg_n(\lambda) \ge q, то добавляем интервал (l, \lambda, p, q) в очередь. Иначе добавляем в очередь (l, \lambda, p, neg_n(\lambda)) и (\lambda, r, neg_n(\lambda) + 1, q).

- Если очередь не пуста, переходим к шагу 3

- Извлекаем интервал (l, r, j) из списка локализованных интервалов

- Если r - l \le \epsilon переходим к шагу 14

- Вычисляем \lambda = (l + r) / 2 и neg_n(\lambda)

- Если neg_n(\lambda) \le p - 1, то l = \lambda, иначе r = \lambda. Переходим к шагу 11

- Запоминаем j-ое собственное значение как (l + r) / 2. Если список локализованных интервалов не пуст, переходим к шагу 10.

1.6 Последовательная сложность алгоритма

Число операций, необходимых для вычисления спектра матрицы зависит от требуемой точности вычислений. Легко видеть, что число операций, необходимых для вычисления neg_n(\lambda) и q_n(\lambda) равно O(N^2). Вычисление начально интервала, содержащего все собственные значения также требует O(N^2) операций. Также нетрудно понять, что число операций, необходимых для приближения локализованного собственного значения с заданной точностью равно O(N^2\log \frac{M}{\epsilon}), где \epsilon - требуемая точность, а M - величина исходного интервала (O(N^2) на каждую итерацию и \log \frac{M}{\epsilon} итераций). Теоретическая оценка числа итераций, необходимых для локализации одного собственного значения неизвестна, однако при достаточно высокой требуемой точности (такой, чтобы после локализации было необходимо дальнейшее приближение собственного значения), это число итераций, очевидно, меньше \log \frac{M}{\epsilon}. Далее, так как необходимо вычислить каждое собственное значение, итоговое число операций равно O(N^3\log \frac{M}{\epsilon}), где N - размерность матрицы, \epsilon - требуемая точность приближения, а M = \|T_n\|_{\infty}. Стоит заметить также, что алгоритм позволяет вычислять не весь спектр сразу, а лишь необходимые k собственных значений. Тогда для этого потребуется O(k N^2\log \frac{M}{\epsilon}) операций.

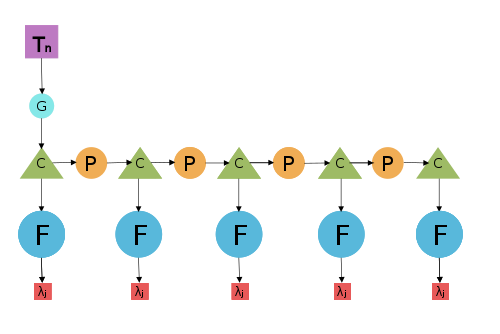

1.7 Информационный граф

Опишем значения вершин информационного графа.

- Вершина T_n обозначает входные данные алгоритма - матрицу T_n

- Вершина G обозначает вычисление интервала, содержащего все собственные значения с помощью кругов Гершгорина

- Вершина C обозначает условный переход при завершении локализации некоторого собственного значения, к его уточнению. Передача данных вниз в графе происходит только при срабатывании условия. Передача данных вправо происходит всегда

- Вершина P обозначает процесс дробления следующего интервала из очереди при локализации собственных значений

- Вершина F обозначает процесс уточнения локализованного собственного значения

- Вершина \lambda_j обозначает выходные данные алгоритма - вычисленное собственное значение

Стоит заметить, что число вершин типов C и P не равно n, а равно количеству необходимых итераций дробления для достижения локализации собственных значений.

1.8 Ресурс параллелизма алгоритма

Глядя на последовательную версию алгоритма, становится ясно, что локализовывать собственные значения можно не в одной последовательной очереди, а разбив номера от 1 до n на d равных частей (где d - число доступных узлов) и инициализировать очередь лишь подотрезком на каждом узле. Также, приближения локализованных собственных значений можно производить независимо на каждом узле. Это означает полную распараллеливаемость алгоритма. Тогда число операций, необходимое для вычисления спектра равно O\Big(\frac{N^3\log \frac{M}{\epsilon}}{d}\Big) при d \lt N. При наличии бесконечного числа узлов, асимптотическая сложность будет равна O(N^2\log \frac{M}{\epsilon}).

1.9 Входные и выходные данные алгоритма

На вход алгоритму подается размер матрицы n и симметрическая теплицева матрица T_n размера n \times n. Также предполагается, что ни одно из собственных значений T_{n} не является собственным значением для T_{1}, \dots, T_{n-1}, однако утверждается, что это ограничение не затрудняет практического применения. Также на вход подается число \epsilon \gt 0 - требуемая абсолютная погрешность вычисления собственных значений.

Результатом работы алгоритма является массив из n вещественных чисел, j-ое из которых с точностью до \epsilon равно j-ому собственному значению матрицы T_n.

1.10 Свойства алгоритма

2 Программная реализация алгоритма

2.1 Особенности реализации последовательного алгоритма

2.2 Локальность данных и вычислений

2.3 Возможные способы и особенности параллельной реализации алгоритма

2.4 Масштабируемость алгоритма и его реализации

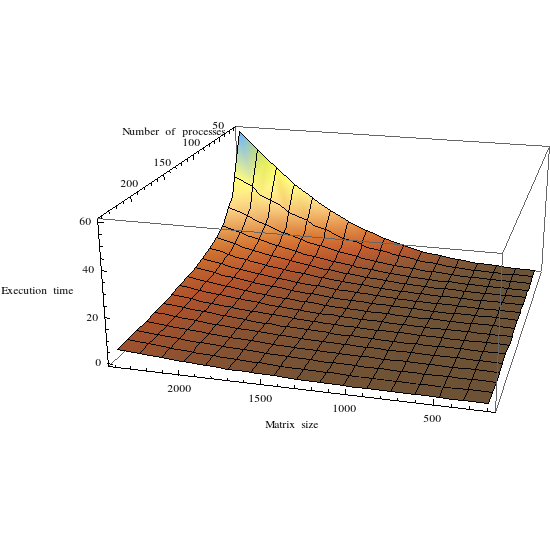

Исследование проводилось на суперкомпьютере "Ломоносов" Суперкомпьютерного комплекса Московского университета. Исходный код был написан на языке C++ с использованием библиотеки Intel MPI (Intel(R) MPI Library for Linux* OS, Version 5.0 Update 1). Компиляция производилась с опциями -O3 -march=native -std=c++0x.

Набор и границы значений изменяемых параметров запуска реализации алгоритма:

число процессоров [20 : 240] с шагом 20;

размер матрицы [200 : 2400] c шагом 200.

На следующем рисунке приведен график времени работы выбранной реализации алгоритма вычисления собственных значений симметрической теплицевой матрицы в зависимости от изменяемых параметров запуска.

Исходный код тестируемой реализации на C++

2.5 Динамические характеристики и эффективность реализации алгоритма

2.6 Выводы для классов архитектур

2.7 Существующие реализации алгоритма

О существующих в популярных пакетах реализациях этого алгоритма ничего не известно в виду не очень широкого круга задач, которые он решает. Все существующие реализации создавались авторами исследований и не публиковались.

3 Литература

- ↑ Е.Е. Тыртышников Основы алгебры. М.: Физматлит, 2017.

- ↑ Е.Е. Тыртышников Методы численного анализа. М.: Издательский центр "Академия", 2007, 320 с.

- ↑ Trench, W. F. (1989). Numerical solution of the eigenvalue problem for Hermitian Toeplitz matrices. SIAM J. Matrix Anal. Appl., 10(2): 135-146

- ↑ F. Noor and S.D. Morgera, Recursive and iterative algorithms for computing eigenvalues of Hermitian Toeplitz matrices, IEEE Trans. Signal Process. 41 (1993) 1272–1280.

- ↑ J. M. Badía and A. M. Vidal, Parallel Algorithms to Compute the Eigenvalues and Eigenvectors of Symmetric Toeplitz Matrices, Parallel Algorithms and Applications, Vol. 13, pp. 75-93. (2000).

- ↑ Noor F., Misbahuddin S. (2010) Using MPI on PC Cluster to Compute Eigenvalues of Hermitian Toeplitz Matrices. In: Hsu CH., Yang L.T., Park J.H., Yeo SS. (eds) Algorithms and Architectures for Parallel Processing. ICA3PP 2010. Lecture Notes in Computer Science, vol 6081. Springer, Berlin, Heidelberg