Участник:KibAndrey/Ортогонализация Грама-Шмидта: различия между версиями

Amelie (обсуждение | вклад) |

Amelie (обсуждение | вклад) |

||

| (не показана 331 промежуточная версия 6 участников) | |||

| Строка 1: | Строка 1: | ||

| + | {{Assignment|ASA|Frolov}} | ||

| + | |||

| + | |||

{{algorithm | {{algorithm | ||

| name = Ортогонализация Грама-Шмидта | | name = Ортогонализация Грама-Шмидта | ||

| − | | serial_complexity = <math>O\left( | + | | serial_complexity = <math>O\left(k^2n\right)</math> |

| − | | pf_height = <math>O( | + | | pf_height = <math>O(kn)</math> |

| pf_width = <math>O(kn)</math> | | pf_width = <math>O(kn)</math> | ||

| input_data = <math>kn</math> | | input_data = <math>kn</math> | ||

| Строка 8: | Строка 11: | ||

}} | }} | ||

| − | |||

| + | Основные авторы описания: [[Участник:KibAndrey| А.В.Кибанов]], [[Участник:Amelie| Т.З.Аджиева]]. | ||

| + | Все пункты данной статьи обсуждались и создавались совместно, доля ответственности равноправна. | ||

| − | = | + | = Свойства и структура алгоритма = |

== Общее описание алгоритма == | == Общее описание алгоритма == | ||

| − | Процесс ортогонализации Грама–Шмидта<ref>Математическая энциклопедия / Гл. ред. | + | '''Процесс ортогонализации Грама–Шмидта'''<ref>Математическая энциклопедия / Гл. ред. |

| − | И. М. Виноградов — М: Советская энциклопедия — Т.4 Ок–Сло, 1984. — 215 с.</ref> — алгоритм построения | + | И. М. Виноградов — М.: Советская энциклопедия — Т.4 Ок–Сло, 1984. — 215 с.</ref> — алгоритм построения ортогональной системы ненулевых векторов по (данной) линейно независимой системе векторов из евклидова или эрмитова пространства V, при котором каждый вектор построенной системы линейно выражается через векторы исходной системы пространства V. |

| − | Funktionen nach Systemen vorgeschriebener. | + | |

| + | Процесс ортогонализации Грама-Шмидта может быть применен к любой, в том числе и линейно-зависимой системе элементов евклидова пространства. Если ортогонализуемая система линейно-зависима, то на некотором шаге (возможно несколько раз) мы получим нулевой элемент, после отбрасывания которого можно продолжить процесс ортогонализации<ref> А. Е. Умнов. Аналитическая геометрия и линейная алгебра — 3-е издание, исправленное и дополненное — М.: МФТИ — 2011 — 544 c.</ref>, однако в данной статье этот случай мы не рассматриваем. | ||

| + | |||

| + | Исторически это первый алгоритм, описывающий процесс ортогонализации. Традиционно его связывают с именами [https://en.wikipedia.org/wiki/J%C3%B8rgen_Pedersen_Gram Йоргена Педерсена Грама] и [https://en.wikipedia.org/wiki/Erhard_Schmidt Эрхарда Шмидта]. Йорган Педерсен Грам<ref name="multiple">Meyer C. D. Matrix analysis and applied linear algebra. — Siam, 2000. — Т.2.</ref> был датским актуарием (специалистом по страховой математике, на современном языке это профессия финансового аналитика), который в неявном виде представил суть процесса ортогонализации в 1883 году<ref>[http://gdz.sub.uni-goettingen.de/dms/load/img/?PID=GDZPPN002158604&physid=PHYS_0047 Gram J. P. Ueber die Entwickelung reeller Functionen in Reihen mittelst der Methode der kleinsten Quadrate.] — ''Journal für die reine und angewandte Mathematik.'' — 1883. — Т. 94. — pp. 41–73.</ref>. Нельзя не сказать о том, что метод ортогонализации в несколько ином, модифицированом виде, ранее использовал [https://en.wikipedia.org/wiki/Pierre-Simon_Laplace Пьер-Симон Лаплас] при нахождении массы Сатурна и Юпитера из систем нормальных уравнений и расчете распределения ошибок при этих вычислениях<ref> [https://books.google.ru/books?id=fjAVAAAAQAAJ&printsec=frontcover&hl=ru&source=gbs_ge_summary_r&cad=0#v=onepage&q&f=false Marquis de Laplace P. S. Théorie analytique des probabilités.] — V. Courcier, 1820.</ref>. Ясно, что Й. Грам не знал о том, что Лаплас ранее использовал этот метод. Эрхард Шмидт<ref name="multiple">Meyer C. D. Matrix analysis and applied linear algebra. — Siam, 2000. — Т.2.</ref> был учеником великих математиков [https://en.wikipedia.org/wiki/Hermann_Schwarz Германа Шварца] и [https://en.wikipedia.org/wiki/David_Hilbert Давида Гильберта]. Алгоритм ортогонализации был опубликован Э. Шмидтом в 1907 году в его исследовании интегральных уравнений<ref name=Shmidt>Erchard Shmidt. Mathematische Annalen Zur Theorie der linearen und nichtlinearen Integralgleichungen, 1. Teil: Entwicklung willkürlicher | ||

| + | Funktionen nach Systemen vorgeschriebener. — Mathematische Annalen. — 1908. — V. 65. — №. 3. — pp. 370-399.</ref>, которое в свою очередь дало основание для развития теории гильбертовых пространств. Шмидт, используя процесс ортогонализации применительно к геометрии гильбертова пространства решений интегральных уравнений, отмечал, что процесс ортогонализации принципиально такой же, какой прежде использовал Й. Грам. В отечественной литературе иногда этот процесс называют ''ортогонализацией Сонина–Шмидта''<ref>Краснов М.Л. Интегральные уравнения. Введение в теорию. — М.: Наука, 1975. — 302 с.</ref><ref>Марченко В.А. Введение в теорию обратных задач спектрального анализа. — Харьков: Акта, 2005. — 143 с.</ref>. Это название связано с тем, что разработанный Сониным<ref>О некоторых неравенствах, относящихся к определенным интегралам. Записки Академии наук по физико-математическому отделению. Серия 8. Т. 6 № 6. — C. 1–53.</ref> метод ортогонализации системы функций для частного случая по существу не отличается от метода ортогонализации системы функций, предложенного ранее Шмидтом<ref name=Shmidt>Erchard Shmidt. Mathematische Annalen Zur Theorie der linearen und nichtlinearen Integralgleichungen, 1. Teil: Entwicklung willkürlicher | ||

Funktionen nach Systemen vorgeschriebener. — Mathematische Annalen, 63 (1907), pp. 433–476.</ref>. | Funktionen nach Systemen vorgeschriebener. — Mathematische Annalen, 63 (1907), pp. 433–476.</ref>. | ||

| + | |||

| + | Процесс ортоганализации Грама-Шмидта лежит в основе многих алгоритмов вычислительной математики. | ||

| + | Классический процесс ортогонализации Грама–Шмидта применяется в таких современных областях науки, как анализ изображений<ref>Nussbaum S., Menz G. Object-based image analysis and treaty verification: new approaches in remote sensing-applied to nuclear facilities in Iran. — Springer Science & Business Media, 2008 — pp 75–81.</ref>, цифровая обработка сигналов<ref>Gopi E. S. Algorithm collections for digital signal processing applications using matlab. — Springer Science & Business Media, 2007.</ref>, нейронные сети<ref>[http://thirdworld.nl/application-of-sequential-learning-neural-networks-to-civil-engineering-modeling-problems Rajasekaran S., Suresh D., Pai G. A. V. Application of sequential learning neural networks to civil engineering modeling problems.] — ''Engineering with Computers.'' — 2002. — Т. 18. — №. 2. — pp. 138–147.</ref>. | ||

== Математическое описание алгоритма == | == Математическое описание алгоритма == | ||

| − | '''Bходные данные:''' <math>k</math> линейно независимых векторов <math>\mathbf{a_1},\mathbf{a_2},\ldots,\mathbf{a_k}</math> | + | Пусть <math>V</math> — евклидово пространство размерности <math>n</math>. |

| + | |||

| + | '''Bходные данные:''' | ||

| + | |||

| + | <math>k</math> линейно независимых векторов <math>\mathbf{a_1},\mathbf{a_2},\ldots,\mathbf{a_k}</math> пространства <math>V</math>. | ||

'''Вычисляемые данные:''' | '''Вычисляемые данные:''' | ||

| − | <math>k</math> ортогональных векторов <math>\mathbf{b_1},\mathbf{b_2},...,\mathbf{b_k}</math> | + | <math>k</math> ортогональных векторов <math>\mathbf{b_1},\mathbf{b_2},...,\mathbf{b_k}</math> пространства <math>V</math>, причем <math>\mathbf{b_1}=\mathbf{a_1}</math>, либо |

| − | <math>k</math> ортонормированных векторов <math>\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_k}</math> | + | <math>k</math> ортонормированных векторов <math>\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_k}</math> пространства <math>V</math>, причем <math>\mathbf{q_i}=\frac{\mathbf{b_i}}{|\mathbf{b_i}|}</math>, <math>i=1,2, \ldots,k</math>. |

'''Формулы процесса ортогонализации:''' | '''Формулы процесса ортогонализации:''' | ||

| Строка 36: | Строка 51: | ||

\begin{align} | \begin{align} | ||

\mathbf{b_{1}} & =\mathbf{a_{1}}, \\ | \mathbf{b_{1}} & =\mathbf{a_{1}}, \\ | ||

| − | \mathbf{b_{2}}& =\mathbf{a_{2}}-proj_{\mathbf{b_1}}\mathbf{a_{ | + | \mathbf{b_{2}}& =\mathbf{a_{2}}-\mathbf{b_{1}} proj_{\mathbf{b_1}}\mathbf{a_{2}},\\ |

| + | |||

& ...\\ | & ...\\ | ||

| − | \mathbf{b_ | + | \mathbf{b_{i}} & =\mathbf{ a_{i}}-\sum\limits_{j=1}^{i-1}\mathbf{b_{i}} proj_{\mathbf{b_j}}\mathbf{a_{i}}.\\ |

& ...\\ | & ...\\ | ||

| − | \mathbf{b_{k}} & =\mathbf{ a_{k}}-\sum\limits_{j=1}^{k-1} proj_{\mathbf{b_j}}\mathbf{a_{k}}.\\ | + | \mathbf{b_{k}} & =\mathbf{ a_{k}}-\sum\limits_{j=1}^{k-1}\mathbf{b_{k}} proj_{\mathbf{b_j}}\mathbf{a_{k}}.\\ |

\end{align} | \end{align} | ||

</math> | </math> | ||

| − | Здесь <math>proj_{\mathbf{b_j}}\mathbf{a_{i}}</math>, для <math>j=1,..., | + | Здесь <math>proj_{\mathbf{b_j}}\mathbf{a_{i}}</math>, для <math>j=1,...,k-1</math> — это модуль проекции вектора <math>\mathbf{a_{j}}</math> на ось, проходящую через вектор <math>\mathbf{b_j}</math>. |

| − | |||

Формула для ее вычисления, полученная из определения скалярного произведения: | Формула для ее вычисления, полученная из определения скалярного произведения: | ||

| − | <math>proj_{\mathbf{b_j}}\mathbf{a_{i}}=\dfrac{( | + | <math>proj_{\mathbf{b_j}}\mathbf{a_{i}}=\dfrac{(\mathbf{a_{i}},\mathbf{b_{j}})}{\mathbf{\left|\mathbf{b_j}\right|}}</math>, для <math>j=1,...,i-1</math>. |

| − | |||

| − | |||

| − | Произведение длин <math>\mathbf{|b_1|},\mathbf{|b_2|},\ldots ,\mathbf{|b_k|}</math> равно объему параллелепипеда, построенного на векторах системы <math>\left\{\mathbf{a_i}\right\}</math>, <math>i=1,2,\ldots ,k</math>, как на ребрах | + | Произведение длин <math>\mathbf{|b_1|},\mathbf{|b_2|},\ldots ,\mathbf{|b_k|}</math> равно объему параллелепипеда, построенного на векторах системы <math>\left\{\mathbf{a_i}\right\}</math>, <math>i=1,2,\ldots ,k</math>, как на ребрах. |

Явное выражение векторов <math>\mathbf{b_i}</math> для <math>i=1,...,k</math> через <math>\mathbf{a_1},\mathbf{a_2},...,\mathbf{a_k}</math> дает формула | Явное выражение векторов <math>\mathbf{b_i}</math> для <math>i=1,...,k</math> через <math>\mathbf{a_1},\mathbf{a_2},...,\mathbf{a_k}</math> дает формула | ||

| Строка 58: | Строка 71: | ||

<math> \mathbf{b_i}= | <math> \mathbf{b_i}= | ||

\begin{vmatrix} | \begin{vmatrix} | ||

| − | (a_1,a_1) & \cdots & (a_1, | + | (a_1,a_1) & \cdots & (a_1,a_i-1) &a_1 \\ |

| − | + | (a_{2},a_1) & \cdots & (a_2,a_i-1) &a_2 \\ | |

| − | (a_{ | ||

\cdots & \cdots & \cdots& \cdots \\ | \cdots & \cdots & \cdots& \cdots \\ | ||

| − | (a_{ | + | (a_{i},a_1) & \cdots & (a_i,a_i-1) &a_i \\ |

\end{vmatrix} | \end{vmatrix} | ||

</math>. | </math>. | ||

(В правой части этого равенства определитель следует формально разложить по последнему столбцу). | (В правой части этого равенства определитель следует формально разложить по последнему столбцу). | ||

| − | Иногда полученные векторы нормируются сразу после их нахождения и находится система ортонормированных векторов <math>\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_k}</math>. В этом случае | + | Иногда полученные векторы нормируются сразу после их нахождения и находится система ортонормированных векторов <math>\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_k}</math>. В этом случае в знаменателе при вычеслении проекции по формуле будет <math>|\mathbf{q_i}|=1</math> для <math>i=1,...,k-1</math>, что существенно упрощает вычисления алгоритма. В настоящей статье применяя процесс ортогонализации к системе линейно независимых векторов, мы так и будем поступать. |

| + | |||

| + | Если в описанном алгоритме в формулах для вычисления векторов <math>\mathbf{b_i}\,</math>, для <math>i=1,...,k</math> процесса ортогонализации заменить <math>proj_{\mathbf{b_j}}\mathbf{a_{i}}</math>, для <math>j=1,...,i-1</math> на <math>proj_{\mathbf{b_j}}\mathbf{b_{i}}</math>, для <math>j=1,...,i-1</math>, алгоритм, полученный таким образом называется ''модифицированным алгоритмом Грама–Шмидта''. | ||

| + | |||

| + | Чаще всего, процесс Грама–Шмидта приводит к значительному нарушению ортогональности. Что касается модифицированного процесса Грама–Шмидта, он проявляет себя достаточно неусточиво, хоть и чуть менее, чем классический процесс. | ||

| + | |||

| + | == Вычислительное ядро алгоритма == | ||

| + | |||

| + | Вычислительное ядро алгоритма состоит из вычисления: | ||

| + | |||

| + | *<math>\dfrac{k(k+1)}{2}</math> [[Скалярное произведение векторов, вещественная версия, последовательно-параллельный вариант| скалярных произведений]] векторов, | ||

| + | включая нахождения скалярных произведений одинаковых векторов дальнейшего нахождения их длин; | ||

| + | |||

| + | *<math>\dfrac{(k-1)k}{2}</math> умножений векторов на число после вычисления нового базисного вектора на итерации. | ||

== Макроструктура алгоритма == | == Макроструктура алгоритма == | ||

| − | Как | + | Как уже отмечено в [[#Вычислительное ядро алгоритма| описании вычислительного ядра алгоритма]], |

| + | основную часть метода составляют вычисления [[Скалярное_произведение_векторов,_вещественная_версия,_последовательный_вариант| скалярных произведений]], | ||

| + | как для вычисления длины очередного вектора, так и для расчета проекций прочих векторов на новый вектор, | ||

| + | а также умножения векторов на числа, используемые при корректировке | ||

| + | значений остальных векторов после вычисления очередного вектора, ортогонального предыдущим. | ||

| + | |||

| + | Таким образом, основновные макрооперации алгоритма: | ||

| + | *вычисления [[Скалярное_произведение_векторов,_вещественная_версия,_последовательно-параллельный_вариант| скалярных произведений]], | ||

| + | *умножения векторов на числа, используемые при корректировке значений остальных векторов после вычисления очередного вектора, ортогонального предыдущим. | ||

| + | |||

| + | Теперь опишем макроструктуру процесса ортогонализации. На верхнем уровне она представляет из себя последовательное вычисление <math>k</math> ортонормированных векторов <math>\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_i},\ldots,\mathbf{q_k}</math>. | ||

| + | |||

| + | |||

| + | 1. При <math>i=1</math>: | ||

| + | |||

| + | ::<math>\mathbf{q_{1}}= \frac{\mathbf{a_{1}}}{\left|\mathbf{a_1}\right|}</math>. | ||

| + | |||

| + | 2. При <math>i=2,...,k</math>: | ||

| + | ::<math>\mathbf{b_{i}}=\mathbf{a_{i}}-\sum\limits_{k=1}^{i-1}(\mathbf{a_i},\mathbf{q_k})\mathbf{q_{k}}</math> | ||

| + | |||

| + | ::<math>\mathbf{q_{i}}=\frac{\mathbf{b_{i}}}{\left|\mathbf{b_i}\right|}</math>. | ||

== Схема реализации последовательного алгоритма == | == Схема реализации последовательного алгоритма == | ||

| Строка 81: | Строка 126: | ||

<math>k</math> ортогональных векторов <math>\mathbf{b_1},\mathbf{b_2},...,\mathbf{b_k}</math> длины <math>n</math> <math>\left(\beta_{ij}\right.</math>, где <math>j=1,2, \ldots,n</math> — координаты вектора <math>\mathbf{b_i}</math>, для <math>\left.i=1,2, \ldots,k\right)</math>, причем <math>\mathbf{b_1}=\mathbf{a_1}</math>, либо | <math>k</math> ортогональных векторов <math>\mathbf{b_1},\mathbf{b_2},...,\mathbf{b_k}</math> длины <math>n</math> <math>\left(\beta_{ij}\right.</math>, где <math>j=1,2, \ldots,n</math> — координаты вектора <math>\mathbf{b_i}</math>, для <math>\left.i=1,2, \ldots,k\right)</math>, причем <math>\mathbf{b_1}=\mathbf{a_1}</math>, либо | ||

| − | <math>k</math> ортонормированных векторов <math>\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_k}</math> длины <math>n</math> (<math>\gamma_{ij}</math>, <math>j=1,2, \ldots,n</math> — координаты вектора <math>\mathbf{ | + | <math>k</math> ортонормированных векторов <math>\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_k}</math> длины <math>n</math> (<math>\gamma_{ij}</math>, <math>j=1,2, \ldots,n</math> — координаты вектора <math>\mathbf{q_i}</math>, для <math>\left.i=1,2, \ldots,k\right)</math>, причем <math>\mathbf{q_1}=\frac{\mathbf{b_i}}{|\mathbf{b_i}|}</math>, для <math>i=1,2, \ldots,k</math>. |

'''Последовательность исполнения метода''': | '''Последовательность исполнения метода''': | ||

| − | 1. <math> | + | 1. <math>|\mathbf{a_1}|=\sqrt{\alpha_{11}^2+\alpha_{12}^2+\ldots+\alpha_{1n}^2}</math>. |

2. При <math>i</math> от <math>1</math> до <math>n</math>: | 2. При <math>i</math> от <math>1</math> до <math>n</math>: | ||

| − | ::<math>\gamma_{1j}= \frac{\alpha_{1j}}{ | + | ::<math>\gamma_{1j}= \frac{\alpha_{1j}}{|\mathbf{a_1}|}</math>. |

3. При <math>i</math> от <math>2</math> до <math>k</math>: | 3. При <math>i</math> от <math>2</math> до <math>k</math>: | ||

| Строка 95: | Строка 140: | ||

:::при <math>j</math> от <math>1</math> до <math>n</math>: | :::при <math>j</math> от <math>1</math> до <math>n</math>: | ||

| − | :::::<math>\beta_{ij}=\alpha_{ij}-\sum\limits_{k=1}^{j-1}\left(\sum\limits_{m=1}^n \alpha_{im}\ | + | :::::<math>\beta_{ij}=\alpha_{ij}-\sum\limits_{k=1}^{j-1}\left(\sum\limits_{m=1}^n \alpha_{im}\gamma_{km}\right)\gamma_{kj} </math> |

| − | ::: <math> | + | ::: <math>|\mathbf{b_i}|=\sqrt{\beta_{i1}^2+\beta_{i2}^2+\ldots+\beta_{in}^2}</math> |

:::при <math>j</math> от <math>1</math> до <math>n</math>: | :::при <math>j</math> от <math>1</math> до <math>n</math>: | ||

| − | ::::::<math>\gamma_{ij}= \frac{\beta_{ij}}{ | + | ::::::<math>\gamma_{ij}= \frac{\beta_{ij}}{|\mathbf{b_{i}}|}</math>. |

| − | |||

| − | |||

== Последовательная сложность алгоритма == | == Последовательная сложность алгоритма == | ||

| − | Для ортогонализации <math> | + | Для ортогонализации <math>k</math> линейно независимых векторов длины <math>n</math> в последовательном варианте с помощью классического метода ортогонализации Грама–Шмидта потребуется: |

* <math>k</math> вычислений квадратного корня | * <math>k</math> вычислений квадратного корня | ||

| Строка 111: | Строка 154: | ||

* <math>\frac{k(k-1)(n-1)}{2}</math> вычитаний, | * <math>\frac{k(k-1)(n-1)}{2}</math> вычитаний, | ||

* <math>k^2 n</math> умножений, | * <math>k^2 n</math> умножений, | ||

| − | * <math>k</math> делений. | + | * <math>k n</math> делений. |

Умножения, сложения и вычитания составляют ''основную часть алгоритма''. | Умножения, сложения и вычитания составляют ''основную часть алгоритма''. | ||

| − | При классификации по последовательной сложности, таким образом, метода ортогонализации | + | При классификации по последовательной сложности, таким образом, метода ортогонализации Грама–Шмидта ''с кубической сложностью''. |

== Информационный граф == | == Информационный граф == | ||

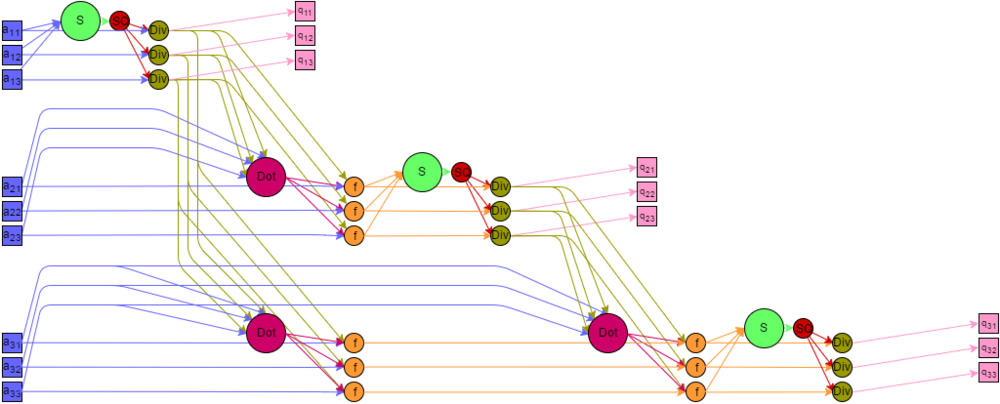

| − | Представим граф алгоритма с помощью текстового описания, а также с помощью изображения. | + | Представим [[глоссарий#Граф алгоритма|граф алгоритма]]<ref>Воеводин В.В. Математические основы параллельных вычислений. — М.: Изд. Моск. ун-та, 1991. — 345 с.</ref><ref>Воеводин В.В., Воеводин Вл.В. Параллельные вычисления. — СПб.: БХВ - Петербург, 2002. — 608 с.</ref><ref>Фролов А.В.. Принципы построения и описание языка Сигма. Препринт ОВМ АН N 236. М.: ОВМ АН СССР, 1989.</ref> с помощью текстового описания, а также с помощью изображения. |

| − | Все вершины графа можно разбить на | + | Все вершины графа можно разбить на пять групп, каждой из которых соответствует вид исполняемой операции. Каждая вершина расположена в точках с целочисленными координатами, в пространствах с числом измерений от <math>1</math> до <math>3</math>. Дадим описание каждой из групп. |

| − | '''Первая''' группа — вершины, которым соответствует операция | + | '''Первая''' группа — вершины, которым соответствует операция скалярного умножения вектора на себя. На графе они располагаются в одномерной области. <math>i</math> изменяется от <math>1</math> до <math>k</math>. |

Значениями аргументов для этих функций являются: | Значениями аргументов для этих функций являются: | ||

| − | * при <math>i = 1</math> — входные данные <math>a_{ | + | * при <math>i = 1</math> — входные данные <math>\{a_{1p}\}, p = 1..n</math>; |

| − | * при <math>i > 1</math> — результат выполнения функции в вершине | + | * при <math>i > 1</math> — результат выполнения функции в вершине пятой группы с координатами <math>\{i-1,1,p\}, p = 1..n</math>. |

| + | |||

| + | Результат этих операций является промежуточным данным алгоритма. | ||

| + | |||

| + | '''Вторая''' группа — вершины, которым соответствует операция SQRT извлечения квадратного корня. Они расположены в одномерной области, <math>i </math> изменяется от <math>1</math> до <math>k</math>. | ||

| + | |||

| + | Значением аргумента для этих функций является результат выполнения функции в вершине первой группы, с координатой <math>i</math>. | ||

| + | |||

Результат является промежуточным данным алгоритма. | Результат является промежуточным данным алгоритма. | ||

| − | ''' | + | '''Третья''' группа — вершины, которым соответствует операция деления. Располагаются в двумерной области, <math>i</math> изменяется от <math>1</math> до <math>k</math>, <math>p</math> изменяется от <math>1</math> до <math>n</math>. |

Значениями аргументов для этих функций являются: | Значениями аргументов для этих функций являются: | ||

| − | * при <math> | + | * делимое: |

| − | * при <math> | + | ** при <math>i = 1</math> — входные данные <math>a_{1p}</math>; |

| − | * | + | ** при <math>i > 1</math> — результат выполнения функции в вершине пятой группы с координатами <math>i-1,1,p</math>; |

| − | + | * делитель - результат выполнения функции в вершине второй группы с координатой <math>i</math>. | |

| − | + | Результат является выходным данным алгоритма <math>q_{ip}</math>. | |

| − | |||

| − | + | '''Четвертая''' группа — вершины, которым соответствует операция скалярного умножения векторов <math>\mathbf{a}\cdot\mathbf{b}</math>. Располагаются в двумерной области, <math>i</math> изменяется от <math>1</math> до <math>k-1</math>, <math>j</math> изменяется от <math>1</math> до <math>k-i</math>. | |

| − | |||

Значениями аргументов для этих функций являются: | Значениями аргументов для этих функций являются: | ||

| − | * | + | * <math>\mathbf{a}</math> — входные данные <math>\{a_{1+j,p}\},p = 1..n </math>; |

| − | + | * <math>\mathbf{b}</math> — результат выполнения функции в вершине третьей группы с координатой <math>\{i,p\}, p = 1..n </math>. | |

| − | * | ||

| − | |||

| − | |||

| − | + | Результат является промежуточным данным алгоритма. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | '''Пятая''' группа — вершины которые соответствуют операции <math>a - b c</math>. Располагаются в трехмерной области, <math>i</math> изменяется от <math>1</math> до <math>k-1</math>, <math>j</math> изменяется от <math>1</math> до <math>k-i</math>, <math>p</math> изменяется от <math>1</math> до <math>n</math>. | |

| − | |||

Значениями аргументов для этих функций являются: | Значениями аргументов для этих функций являются: | ||

* <math>a</math>: | * <math>a</math>: | ||

| − | ** при <math>i = 1</math> — входные данные <math>a_{1+j, | + | ** при <math>i = 1</math> — входные данные <math>a_{1+j,p}</math>; |

| − | ** при <math>i > 1</math> — результат выполнения функции в вершине | + | ** при <math>i > 1</math> — результат выполнения функции в вершине пятой группы с координатами <math>i-1,j+1,p</math>; |

| − | * <math>b</math> — результат выполнения функции в вершине | + | * <math>b</math> — результат выполнения функции в вершине четвертой группы, с координатами <math>i,j</math>; |

| − | * <math>c</math> — результат выполнения функции в вершине | + | * <math>c</math> — результат выполнения функции в вершине третьей группы с координатой <math>i,p</math>. |

| + | |||

Результат является промежуточным данным алгоритма. | Результат является промежуточным данным алгоритма. | ||

| − | Описанный граф для случая <math> | + | Описанный граф для случая <math>k = 3</math>, <math>n = 3</math> изображен на рисунке. Каждая группа вершин отличается цветом и буквенным обозначением. "S" — первая группа, "SQ" — вторая группа, "Div" — третья группа, "Dot" — четвертая группа, "f" — пятая группа. Квадратные метки синего и розового цветов обозначают передачу входных и выходных данных соответственно. |

| − | [[File:GSParallelDiagram.png|thumb|center| | + | [[File:GSParallelDiagram.png|thumb|center|1000px|Рисунок 1. Граф алгоритма с отображением входных и выходных данных]] |

== Ресурс параллелизма алгоритма == | == Ресурс параллелизма алгоритма == | ||

Для построения ортонормированного базиса методом Грама–Шмидта необходимо выполнить следующие ярусы операций: | Для построения ортонормированного базиса методом Грама–Шмидта необходимо выполнить следующие ярусы операций: | ||

| − | *<math>k</math> ярусов вычисления | + | *<math>k</math> ярусов вычисления скалярных произведений векторов на самих себя (по одной операций на каждом, сложность операции по высоте и по ширине [[глоссарий#Ярусно-параллельная форма графа алгоритма|ЯПФ]] — <math>O(n)</math> и <math>O(1)</math> соответственно); |

| − | |||

*<math>k</math> ярусов вычисления квадратного корня (по одной операции на каждом); | *<math>k</math> ярусов вычисления квадратного корня (по одной операции на каждом); | ||

| − | *<math>k</math> ярусов деления( по <math> | + | *<math>k</math> ярусов деления (по <math>n</math> операций на каждом); |

| − | *<math>k-1</math> ярус | + | *<math>k-1</math> ярус вычисления [[Скалярное_произведение_векторов,_вещественная_версия,_последовательный_вариант| скалярных произведений]] пары векторов (от <math>1</math> до <math>(k-1)</math> операций на каждом,сложность операции по высоте ЯПФ — O(n), по ширине - O(1)); |

*<math>k-1</math> ярус умножения/вычитания чисел (от <math>n</math> до <math>(k-1)n</math> операций на каждом). | *<math>k-1</math> ярус умножения/вычитания чисел (от <math>n</math> до <math>(k-1)n</math> операций на каждом). | ||

| − | В этом случае сложность алгоритма при классификации по высоте ЯПФ — <math>O( | + | В этом случае сложность алгоритма при классификации по высоте ЯПФ — <math>O(kn)</math>, при классификации по ширине ЯПФ — <math>O(kn)</math>. |

== Входные и выходные данные алгоритма == | == Входные и выходные данные алгоритма == | ||

| − | '''Входные данные''': | + | |

| + | '''Входные данные''': матрица <math>A</math> с элементами <math>\alpha_{ij}</math>, | ||

| + | где <math>i</math> принимает значения <math>1,\ldots,k</math>, <math>j</math> принимает значения <math> 1,\ldots,n</math>. | ||

| + | Здесь <math>k\leqslant n</math>. По строкам этой матрицы записаны <math>k</math> | ||

| + | линейно-независимых векторов некоторого пространства размерности <math>n</math>. | ||

'''Объем входных данных''': <math>kn</math>. | '''Объем входных данных''': <math>kn</math>. | ||

| − | '''Выходные данные''': | + | '''Выходные данные''': матрица <math>Q</math> с элементами <math>\gamma_{ij}</math>. Строки этой матрицы также задают <math>k</math> векторов единичной длины размерности <math>n</math>, причем всякое скалярное произведение двух различных векторов этой системы равно <math>0</math>. |

| − | '''Объем выходных данных''': <math>kn</math> | + | '''Объем выходных данных''': <math>kn</math>. |

| − | Замечание: Алгоритм может работать с вырожденной матрицей, он выдаёт нулевую строку на шаге <math>j</math>, если строка <math>j</math> матрицы <math>A</math> является линейной комбинацией предыдущих строк. В этом случае для корректного продолжения работы алгоритма необходима дополнительная проверка на равенство строки нулю и пропуск соответствующих строк. Количество построенных векторов будет равняться размерности пространства, порождаемого строками матрицы. | + | Замечание: Алгоритм может работать с вырожденной матрицей, он выдаёт нулевую строку на шаге <math>j</math>, |

| + | если строка <math>j</math> матрицы <math>A</math> является линейной комбинацией предыдущих строк. | ||

| + | В этом случае для корректного продолжения работы алгоритма необходима | ||

| + | дополнительная проверка на равенство строки нулю и пропуск соответствующих строк. | ||

| + | Количество построенных векторов будет равняться размерности пространства, порождаемого строками матрицы. | ||

== Свойства алгоритма == | == Свойства алгоритма == | ||

| − | Отношение последовательной и параллельной сложности алгоритма в случае неограниченных ресурсов равно <math>\dfrac{k^2n}{ | + | |

| + | Отношение последовательной и параллельной сложности алгоритма в случае неограниченных ресурсов равно <math>\dfrac{k^2n}{kn}=k</math>. | ||

Вычислительная мощность алгоритма линейная. | Вычислительная мощность алгоритма линейная. | ||

| − | Алгоритм почти полностью детерминирован | + | Алгоритм почти полностью детерминирован — единственность результата выполнения гарантирована, однако возможно накопление ошибок округления. |

| − | Алгоритм является численно неустойчивым | + | Алгоритм является численно неустойчивым — ошибки округления могут привести к неортогональности полученных векторов. |

| − | Большинство дуг информационного графа являются локальными. Исключение составляют дуги исходящие из операций деления и извлечения корня | + | Большинство дуг информационного графа являются локальными. Исключение составляют дуги исходящие из операций деления и извлечения корня — для первой группы количество дуг пропорционально квадрату количества векторов, а для второй — пропорционально размерности пространства, в котором заданы эти вектора. Возникающие при это длинные дуги могут быть заменены несколькими короткими пересылками между соседями. |

| − | = | + | = Программная реализация алгоритма = |

== Особенности реализации последовательного алгоритма == | == Особенности реализации последовательного алгоритма == | ||

| Строка 210: | Строка 258: | ||

== Возможные способы и особенности параллельной реализации алгоритма == | == Возможные способы и особенности параллельной реализации алгоритма == | ||

| + | |||

| + | Анализ последовательной реализации алгоритма Грама-Шмидта с помощью инструмента [http://valgrind.org/docs/manual/cl-manual.html callgrind] показывает, что наибольшую долю <math>\big(</math>более 97% для <math>k=n=512\big)</math> процессорного времени использует процесс вычитания проекций нормированного вектора от остальных векторов. Этот процесс состоит из вложенных циклов - в одном из циклов происходит итерация по векторам, а в другом — по подпространствам. Таким образом, задача допускает следующие варианты параллельных реализаций: | ||

| + | * Распараллеливание по векторам. | ||

| + | Векторы распределяются по MPI-процессам. После нормировки очередного вектора процесс рассылает его остальным с помощью процедур групповой коммуникации. В исследуемой реализации используется вызов MPI_Bcast. | ||

| + | * Распараллеливание по векторам (b). | ||

| + | Так как рассылать очередной вектор необходимо не всем процессам, а только тем, которые содержат ещё не обработанные векторы, перед вызовом Bcast можно создавать новый коммуникатор, содержащий только необходимые процессы. Оптимальность данного способа реализации не исследовалась. | ||

| + | * Распараллеливание по подпространствам. | ||

| + | Так как последовательная программа содержит операции скалярного произведения, можно назначить каждому MPI-процессу некоторое подпространство. Скалярное произведение при этом подсчитывается при помощи операции Allreduce. | ||

| + | Данная реализация является менее оптимальной, так как содержит <math>\frac{k(k-1)}{2}</math> операций групповой коммуникации, в отличие от k операций для предыдущих реализаций. | ||

| + | |||

| + | Недостаток '''параллельной реализации классического алгоритма Грама-Шмидта'''<ref>Dongarra J., Madsen K., Wasniewski J. Applied Parallel Computing: State of the Art in Scientific Computing. – Springer Science & Business Media, 2006. – V. 3732.</ref> в том, что для матриц с высоким числом обусловленности на входе, система векторов на выходе алгоритма не всегда ортогональна<ref>Björck Å. Numerics of gram-schmidt orthogonalization //Linear Algebra and Its Applications. – 1994. – V. 197. – pp. 297-316.</ref>. | ||

| + | |||

| + | '''Итеративно-параллельный классический алгоритм Грама-Шмидта''' cодержит процедуру итеративной реортогонализации, который даёт возможность избежать недостатков предыдущего метода<ref>[http://www.cerfacs.fr/algor/reports/2002/TR_PA_02_33.pdf Giraud L., Langou J., Rozloznık M. On the round-off error analysis of the Gram-Schmidt algorithm with reorthogonalization.] — ''Technical Report TR/PA/02/33'', CERFACS, Toulouse, France, 2002.</ref>. | ||

| + | |||

| + | '''Блочно-параллельный алгоритм Грама-Шмидта'''<ref>[http://onlinelibrary.wiley.com/doi/10.1002/1099-1506(200005)7:4%3C219::AID-NLA196%3E3.0.CO;2-L/epdf Vanderstraeten D. An accurate parallel block Gram–Schmidt algorithm without reorthogonalization.] — ''Numerical linear algebra with applications.''' — 2000. — V. 7. — №. 4. — pp. 219-236.</ref> — версия параллельного алгоритма Грама-Шмидта, использующая оптимизированные по использованию кэша матричные операции<ref> Dongarra J. J. et al. An extended set of Fortran basic linear algebra subroutines — ''ACM Trans. Math. Soft.'' — 1988. — V. 14. — №. 1. — pp. 1-17.</ref><ref>[http://www.maths.manchester.ac.uk/~sven/pubs/Level3BLAS-1-TOMS16-90.pdf Dongarra J. J. et al. A set of level 3 basic linear algebra subprograms.] — ''ACM Transactions on Mathematical Software (TOMS)'' — 1990. — V. 16. — №. 1. — pp. 1-17.</ref>. | ||

== Масштабируемость алгоритма и его реализации == | == Масштабируемость алгоритма и его реализации == | ||

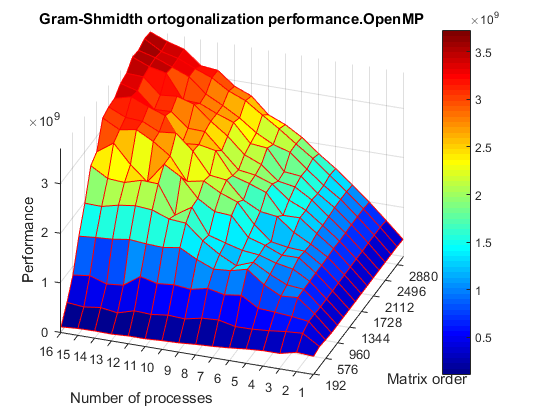

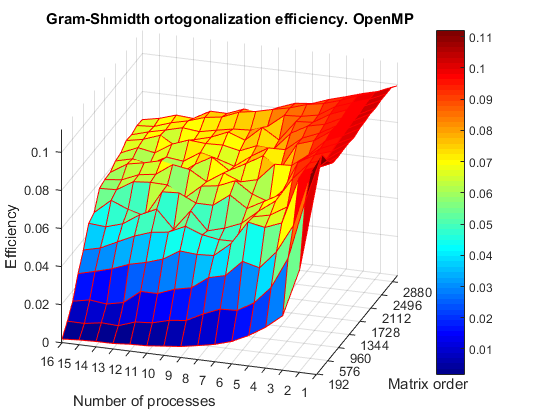

| − | + | Проводились исследования двух параллельных реализаций метода ортогонализации Грама-Шмидта с использованием OpenMP и MPI. | |

| + | |||

| + | Для OpenMP версии проводились испытания на суперкомпьютере [http://hpc.cs.msu.ru/regatta IBM Regatta суперкомпьютерного комплекса Московского университета] | ||

| + | |||

| + | Код был скомпилирован gcc 4.3.2, стандарт c++11, с флагом -O3. со следующими значениями параметров: | ||

| + | *число процессоров [1:16] с шагом 1; | ||

| + | *размер матрицы [192:3072] с шагом 192. | ||

| + | |||

| + | |||

| + | В результате экспериментов получен следующий диапазон значений эффективности реализации алгоритма: | ||

| + | *минимальная эффективность реализации 0.20%; | ||

| + | *максимальная эффективность реализации 11.18%. | ||

| + | |||

| + | На рисунках приведены графики производительности и эффективность исследованной реализации алгоритма в зависимости от числа процессоров и размера матрицы. | ||

| + | |||

| + | [[File:GSOMPperformance.png|thumb|center|720px|Рисунок 2. График производительности OpenMP реализации алгоритма в зависимости от числа процессоров и размера входной матрицы]] | ||

| + | |||

| + | [[File:GsOMPefficiency.png|thumb|center|720px|Рисунок 3. График эффективности OpenMP реализации алгоритма в зависимости от числа процессоров и размера входной матрицы]] | ||

| + | <br clear="all" /> | ||

| + | Оценим значения масштабируемости данной реализации: | ||

| + | *По размеру задачи: 0.0002905. При увеличении размерности задачи эффективность алгоритма медленно возрастает. Если рассматривать изменение эффективности при фиксированном числе процессоров, то большему числу процессоров соответствует более быстрый рост эффективности, начинающийся от более низкого начального значения. Малое значение масштабируемости по этому параметру говорит о слабом росте во всей области рассмотренных параметров. | ||

| + | *По числу процессоров: -0.0002463. С увеличением значения этой характеристики наблюдается слабое снижение эффективности работы параллельной реализации алгоритма. Эффективность снижается на всей области параметров, однако при большей размерности задачи явление начинает проявляться при больших значениях числа процессоров. Это связано с ростом накладных расходов на обеспечение их работы и взаимодействия. При слишком высоком числе процессоров, использованных для решения задачи малой размерности на эти побочные расходы может приходиться основная доля задействованных ресурсов. | ||

| + | *По двум направлениям: 0.0000015. Еще более низкий по сравнению с предыдущими характеристиками порядок этой величины свидетельствует о том, что рост эффективности при одновременном увеличении параметров запуска на значения соответствующих шагов хотя и присутствует, но является практически незначительным. | ||

| + | |||

| + | |||

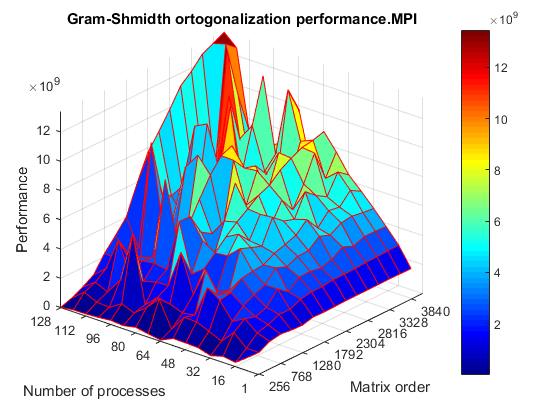

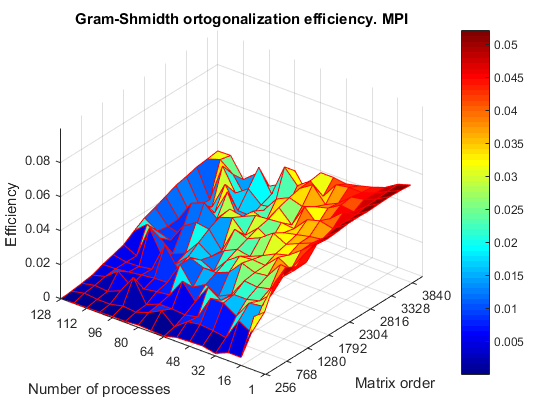

| + | Для MPI версии испытания проводились на суперкомпьютере "Ломоносов" [http://parallel.ru/cluster Суперкомпьютерного комплекса Московского университета]. Для компиляции параллельной программы использовалась версия компилятора intel/13.1.0 с ключом компиляции -O3, стандарт c++11, версия библиотеки Intel MPI impi/4.0.3, запуск проводился на очереди test со следующими значениями параметров: | ||

| + | *число процессоров [8:128] с шагом 8; | ||

| + | *размер матрицы [256:3840] с шагом 256. | ||

| + | |||

| + | В результате экспериментов получен следующий диапазон значений эффективности реализации алгоритма: | ||

| + | *минимальная эффективность реализации 0.008%; | ||

| + | *максимальная эффективность реализации 10.00%. | ||

| + | |||

| + | На рисунках приведены графики производительности и эффективность исследованной реализации алгоритма в зависимости от числа процессоров и размера матрицы. | ||

| + | |||

| + | [[File:GSMPIPerformance.png|thumb|center|720px|Рисунок 4. График производительности MPI реализации алгоритма в зависимости от числа процессоров и размера входной матрицы]] | ||

| + | |||

| + | [[File:GSMPIEfficiency.png|thumb|center|720px|Рисунок 5. График эффективности MPI реализации алгоритма в зависимости от числа процессоров и размера входной матрицы]] | ||

| + | <br clear="all" /> | ||

| + | Аналогично с предыдущей, оценим значения масштабируемости данной реализации, поведение алгоритма во многом схоже: | ||

| + | *По размеру задачи: 0.0001318. Аналогично OpenMP, при увеличении размерности задачи эффективность алгоритма возрастает, несмотря на разброс значений. Большему числу процессоров также соответствует более быстрый рост эффективности. Малое положительное значение масштабируемости по этому параметру говорит о слабом росте во всей области рассмотренных параметров. | ||

| + | *По числу процессоров: -0.0003073. Снижение эффективности реализации алгоритма также связано с растущими накладными расходами, в частности на пересылки данных между процессорами. | ||

| + | *По двум направлениям: -0.000006103. По сравнению с OpenMP реализацией здесь общая масштабируемость имеет отрицательное значение, однако столь же малое абсолютное значение. Общее снижение эффективности с одновременным увеличением параметров выполнения алгоритма слабо выражено. | ||

| + | |||

| + | |||

| + | Число математических операций в исследуемом параллельном алгоритме пропорционально <math>\frac{1}{p}</math>, где <math>p</math> - число параллельных процессов, поэтому для большого числа процессов значительное время занимают операции групповой коммуникации. | ||

| + | Эффективность работы процедуры MPI_Bcast зависит от топологии коммуникационной сети. Например, передача данных между ядрами одного узла происходит на порядки быстрее, чем на ядра соседнего узла. Таким образом, MPI_Bcast работает наиболее эффективно, когда задействованы все ядра некоторого числа узлов. | ||

| + | |||

| + | Мы предполагаем, что множественные особенности графиков для реализации с MPI связаны с тем, что на некоторых конфигурациях запуска были загружены не все ядра одного из узлов. Кроме того, если число векторов не делилось на число процессов, некоторые процессы хранили меньше векторов, чем остальные, что уменьшало эффективность работы параллельного алгоритма. | ||

| + | |||

| + | [https://bitbucket.org/kibandrey/gram-shmidt-orthogonalization/src/d720b3d3fbdd07e9d839992635cc67d2efe29522 Исследованные реализации алгоритма] | ||

== Динамические характеристики и эффективность реализации алгоритма == | == Динамические характеристики и эффективность реализации алгоритма == | ||

| Строка 219: | Строка 332: | ||

== Существующие реализации алгоритма == | == Существующие реализации алгоритма == | ||

| + | Для классического метода ортогонализации Грама–Шмидта существуют реализации в математических программных пакетах, таких как | ||

| + | :*[http://maxima.sourceforge.net/docs/manual/maxima_23.html#gramschmidt Maxima], | ||

| + | :*[https://reference.wolfram.com/language/ref/Orthogonalize.html# Mathematica], | ||

| + | :*[https://www.mathworks.com/help/matlab/ref/cgs.html Matlab]. | ||

| + | Также метод реализован в библиотеке [http://www.spectralpython.net/class_func_ref.html#spectral.algorithms.algorithms.orthogonalize SpectralPython] для языка Python. Для устранения проблемы ошибок численных округлений иногда используется повторное применение метода к уже построенному ортогональному базису. | ||

| + | |||

| + | Поскольку метод ортогонализации Грама–Шмидта гарантирует получение <math>j</math> ортогональных векторов к концу шага <math>j</math>, а не в самом конце работы алгоритма, используется в итерационных методах, таких как метод Арнольди. Для поддержки работы этого метода реализация ортогонализации Грама–Шмидта включена в библиотеку [http://trac.alcf.anl.gov/projects/libs/browser/ARPACK/PARPACK/SRC/MPI/pzgetv0.f/ ARPACK]. | ||

= Литература = | = Литература = | ||

| − | |||

| − | |||

[[en: Gram–Schmidt Orthogonalization]] | [[en: Gram–Schmidt Orthogonalization]] | ||

Текущая версия на 10:04, 14 сентября 2017

| Эта работа успешно выполнена Преподавателю: в основное пространство, в подстраницу Данное задание было проверено и зачтено. Проверено Frolov и ASA. |

| Ортогонализация Грама-Шмидта | |

| Последовательный алгоритм | |

| Последовательная сложность | [math]O\left(k^2n\right)[/math] |

| Объём входных данных | [math]kn[/math] |

| Объём выходных данных | [math]kn[/math] |

| Параллельный алгоритм | |

| Высота ярусно-параллельной формы | [math]O(kn)[/math] |

| Ширина ярусно-параллельной формы | [math]O(kn)[/math] |

Основные авторы описания: А.В.Кибанов, Т.З.Аджиева.

Все пункты данной статьи обсуждались и создавались совместно, доля ответственности равноправна.

Содержание

- 1 Свойства и структура алгоритма

- 1.1 Общее описание алгоритма

- 1.2 Математическое описание алгоритма

- 1.3 Вычислительное ядро алгоритма

- 1.4 Макроструктура алгоритма

- 1.5 Схема реализации последовательного алгоритма

- 1.6 Последовательная сложность алгоритма

- 1.7 Информационный граф

- 1.8 Ресурс параллелизма алгоритма

- 1.9 Входные и выходные данные алгоритма

- 1.10 Свойства алгоритма

- 2 Программная реализация алгоритма

- 2.1 Особенности реализации последовательного алгоритма

- 2.2 Локальность данных и вычислений

- 2.3 Возможные способы и особенности параллельной реализации алгоритма

- 2.4 Масштабируемость алгоритма и его реализации

- 2.5 Динамические характеристики и эффективность реализации алгоритма

- 2.6 Выводы для классов архитектур

- 2.7 Существующие реализации алгоритма

- 3 Литература

1 Свойства и структура алгоритма

1.1 Общее описание алгоритма

Процесс ортогонализации Грама–Шмидта[1] — алгоритм построения ортогональной системы ненулевых векторов по (данной) линейно независимой системе векторов из евклидова или эрмитова пространства V, при котором каждый вектор построенной системы линейно выражается через векторы исходной системы пространства V.

Процесс ортогонализации Грама-Шмидта может быть применен к любой, в том числе и линейно-зависимой системе элементов евклидова пространства. Если ортогонализуемая система линейно-зависима, то на некотором шаге (возможно несколько раз) мы получим нулевой элемент, после отбрасывания которого можно продолжить процесс ортогонализации[2], однако в данной статье этот случай мы не рассматриваем.

Исторически это первый алгоритм, описывающий процесс ортогонализации. Традиционно его связывают с именами Йоргена Педерсена Грама и Эрхарда Шмидта. Йорган Педерсен Грам[3] был датским актуарием (специалистом по страховой математике, на современном языке это профессия финансового аналитика), который в неявном виде представил суть процесса ортогонализации в 1883 году[4]. Нельзя не сказать о том, что метод ортогонализации в несколько ином, модифицированом виде, ранее использовал Пьер-Симон Лаплас при нахождении массы Сатурна и Юпитера из систем нормальных уравнений и расчете распределения ошибок при этих вычислениях[5]. Ясно, что Й. Грам не знал о том, что Лаплас ранее использовал этот метод. Эрхард Шмидт[3] был учеником великих математиков Германа Шварца и Давида Гильберта. Алгоритм ортогонализации был опубликован Э. Шмидтом в 1907 году в его исследовании интегральных уравнений[6], которое в свою очередь дало основание для развития теории гильбертовых пространств. Шмидт, используя процесс ортогонализации применительно к геометрии гильбертова пространства решений интегральных уравнений, отмечал, что процесс ортогонализации принципиально такой же, какой прежде использовал Й. Грам. В отечественной литературе иногда этот процесс называют ортогонализацией Сонина–Шмидта[7][8]. Это название связано с тем, что разработанный Сониным[9] метод ортогонализации системы функций для частного случая по существу не отличается от метода ортогонализации системы функций, предложенного ранее Шмидтом[6].

Процесс ортоганализации Грама-Шмидта лежит в основе многих алгоритмов вычислительной математики. Классический процесс ортогонализации Грама–Шмидта применяется в таких современных областях науки, как анализ изображений[10], цифровая обработка сигналов[11], нейронные сети[12].

1.2 Математическое описание алгоритма

Пусть [math]V[/math] — евклидово пространство размерности [math]n[/math].

Bходные данные:

[math]k[/math] линейно независимых векторов [math]\mathbf{a_1},\mathbf{a_2},\ldots,\mathbf{a_k}[/math] пространства [math]V[/math].

Вычисляемые данные:

[math]k[/math] ортогональных векторов [math]\mathbf{b_1},\mathbf{b_2},...,\mathbf{b_k}[/math] пространства [math]V[/math], причем [math]\mathbf{b_1}=\mathbf{a_1}[/math], либо

[math]k[/math] ортонормированных векторов [math]\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_k}[/math] пространства [math]V[/math], причем [math]\mathbf{q_i}=\frac{\mathbf{b_i}}{|\mathbf{b_i}|}[/math], [math]i=1,2, \ldots,k[/math].

Формулы процесса ортогонализации:

- [math] \begin{align} \mathbf{b_{1}} & =\mathbf{a_{1}}, \\ \mathbf{b_{2}}& =\mathbf{a_{2}}-\mathbf{b_{1}} proj_{\mathbf{b_1}}\mathbf{a_{2}},\\ & ...\\ \mathbf{b_{i}} & =\mathbf{ a_{i}}-\sum\limits_{j=1}^{i-1}\mathbf{b_{i}} proj_{\mathbf{b_j}}\mathbf{a_{i}}.\\ & ...\\ \mathbf{b_{k}} & =\mathbf{ a_{k}}-\sum\limits_{j=1}^{k-1}\mathbf{b_{k}} proj_{\mathbf{b_j}}\mathbf{a_{k}}.\\ \end{align} [/math]

Здесь [math]proj_{\mathbf{b_j}}\mathbf{a_{i}}[/math], для [math]j=1,...,k-1[/math] — это модуль проекции вектора [math]\mathbf{a_{j}}[/math] на ось, проходящую через вектор [math]\mathbf{b_j}[/math].

Формула для ее вычисления, полученная из определения скалярного произведения: [math]proj_{\mathbf{b_j}}\mathbf{a_{i}}=\dfrac{(\mathbf{a_{i}},\mathbf{b_{j}})}{\mathbf{\left|\mathbf{b_j}\right|}}[/math], для [math]j=1,...,i-1[/math].

Произведение длин [math]\mathbf{|b_1|},\mathbf{|b_2|},\ldots ,\mathbf{|b_k|}[/math] равно объему параллелепипеда, построенного на векторах системы [math]\left\{\mathbf{a_i}\right\}[/math], [math]i=1,2,\ldots ,k[/math], как на ребрах.

Явное выражение векторов [math]\mathbf{b_i}[/math] для [math]i=1,...,k[/math] через [math]\mathbf{a_1},\mathbf{a_2},...,\mathbf{a_k}[/math] дает формула

[math] \mathbf{b_i}= \begin{vmatrix} (a_1,a_1) & \cdots & (a_1,a_i-1) &a_1 \\ (a_{2},a_1) & \cdots & (a_2,a_i-1) &a_2 \\ \cdots & \cdots & \cdots& \cdots \\ (a_{i},a_1) & \cdots & (a_i,a_i-1) &a_i \\ \end{vmatrix} [/math]. (В правой части этого равенства определитель следует формально разложить по последнему столбцу).

Иногда полученные векторы нормируются сразу после их нахождения и находится система ортонормированных векторов [math]\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_k}[/math]. В этом случае в знаменателе при вычеслении проекции по формуле будет [math]|\mathbf{q_i}|=1[/math] для [math]i=1,...,k-1[/math], что существенно упрощает вычисления алгоритма. В настоящей статье применяя процесс ортогонализации к системе линейно независимых векторов, мы так и будем поступать.

Если в описанном алгоритме в формулах для вычисления векторов [math]\mathbf{b_i}\,[/math], для [math]i=1,...,k[/math] процесса ортогонализации заменить [math]proj_{\mathbf{b_j}}\mathbf{a_{i}}[/math], для [math]j=1,...,i-1[/math] на [math]proj_{\mathbf{b_j}}\mathbf{b_{i}}[/math], для [math]j=1,...,i-1[/math], алгоритм, полученный таким образом называется модифицированным алгоритмом Грама–Шмидта.

Чаще всего, процесс Грама–Шмидта приводит к значительному нарушению ортогональности. Что касается модифицированного процесса Грама–Шмидта, он проявляет себя достаточно неусточиво, хоть и чуть менее, чем классический процесс.

1.3 Вычислительное ядро алгоритма

Вычислительное ядро алгоритма состоит из вычисления:

- [math]\dfrac{k(k+1)}{2}[/math] скалярных произведений векторов,

включая нахождения скалярных произведений одинаковых векторов дальнейшего нахождения их длин;

- [math]\dfrac{(k-1)k}{2}[/math] умножений векторов на число после вычисления нового базисного вектора на итерации.

1.4 Макроструктура алгоритма

Как уже отмечено в описании вычислительного ядра алгоритма, основную часть метода составляют вычисления скалярных произведений, как для вычисления длины очередного вектора, так и для расчета проекций прочих векторов на новый вектор, а также умножения векторов на числа, используемые при корректировке значений остальных векторов после вычисления очередного вектора, ортогонального предыдущим.

Таким образом, основновные макрооперации алгоритма:

- вычисления скалярных произведений,

- умножения векторов на числа, используемые при корректировке значений остальных векторов после вычисления очередного вектора, ортогонального предыдущим.

Теперь опишем макроструктуру процесса ортогонализации. На верхнем уровне она представляет из себя последовательное вычисление [math]k[/math] ортонормированных векторов [math]\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_i},\ldots,\mathbf{q_k}[/math].

1. При [math]i=1[/math]:

- [math]\mathbf{q_{1}}= \frac{\mathbf{a_{1}}}{\left|\mathbf{a_1}\right|}[/math].

2. При [math]i=2,...,k[/math]:

- [math]\mathbf{b_{i}}=\mathbf{a_{i}}-\sum\limits_{k=1}^{i-1}(\mathbf{a_i},\mathbf{q_k})\mathbf{q_{k}}[/math]

- [math]\mathbf{q_{i}}=\frac{\mathbf{b_{i}}}{\left|\mathbf{b_i}\right|}[/math].

1.5 Схема реализации последовательного алгоритма

Входные данные: [math]k[/math] линейно независимых векторов [math]\mathbf{a_1},\mathbf{a_2},\ldots,\mathbf{a_k}[/math] длины [math]n[/math] [math]\left(\alpha_{ij}\right.[/math], где [math]j=1,2, \ldots,n[/math] — координаты вектора [math]\mathbf{a_i}[/math], для [math]\left.i=1,2, \ldots,k\right)[/math].

Вычисляемые данные:

[math]k[/math] ортогональных векторов [math]\mathbf{b_1},\mathbf{b_2},...,\mathbf{b_k}[/math] длины [math]n[/math] [math]\left(\beta_{ij}\right.[/math], где [math]j=1,2, \ldots,n[/math] — координаты вектора [math]\mathbf{b_i}[/math], для [math]\left.i=1,2, \ldots,k\right)[/math], причем [math]\mathbf{b_1}=\mathbf{a_1}[/math], либо

[math]k[/math] ортонормированных векторов [math]\mathbf{q_1},\mathbf{q_2},\ldots,\mathbf{q_k}[/math] длины [math]n[/math] ([math]\gamma_{ij}[/math], [math]j=1,2, \ldots,n[/math] — координаты вектора [math]\mathbf{q_i}[/math], для [math]\left.i=1,2, \ldots,k\right)[/math], причем [math]\mathbf{q_1}=\frac{\mathbf{b_i}}{|\mathbf{b_i}|}[/math], для [math]i=1,2, \ldots,k[/math].

Последовательность исполнения метода:

1. [math]|\mathbf{a_1}|=\sqrt{\alpha_{11}^2+\alpha_{12}^2+\ldots+\alpha_{1n}^2}[/math].

2. При [math]i[/math] от [math]1[/math] до [math]n[/math]:

- [math]\gamma_{1j}= \frac{\alpha_{1j}}{|\mathbf{a_1}|}[/math].

3. При [math]i[/math] от [math]2[/math] до [math]k[/math]:

- при [math]j[/math] от [math]1[/math] до [math]n[/math]:

- [math]\beta_{ij}=\alpha_{ij}-\sum\limits_{k=1}^{j-1}\left(\sum\limits_{m=1}^n \alpha_{im}\gamma_{km}\right)\gamma_{kj} [/math]

- [math]|\mathbf{b_i}|=\sqrt{\beta_{i1}^2+\beta_{i2}^2+\ldots+\beta_{in}^2}[/math]

- при [math]j[/math] от [math]1[/math] до [math]n[/math]:

- [math]\gamma_{ij}= \frac{\beta_{ij}}{|\mathbf{b_{i}}|}[/math].

- при [math]j[/math] от [math]1[/math] до [math]n[/math]:

1.6 Последовательная сложность алгоритма

Для ортогонализации [math]k[/math] линейно независимых векторов длины [math]n[/math] в последовательном варианте с помощью классического метода ортогонализации Грама–Шмидта потребуется:

- [math]k[/math] вычислений квадратного корня

- [math]\frac{k(k-1)(n-1)}{2}[/math] сложений,

- [math]\frac{k(k-1)(n-1)}{2}[/math] вычитаний,

- [math]k^2 n[/math] умножений,

- [math]k n[/math] делений.

Умножения, сложения и вычитания составляют основную часть алгоритма.

При классификации по последовательной сложности, таким образом, метода ортогонализации Грама–Шмидта с кубической сложностью.

1.7 Информационный граф

Представим граф алгоритма[13][14][15] с помощью текстового описания, а также с помощью изображения.

Все вершины графа можно разбить на пять групп, каждой из которых соответствует вид исполняемой операции. Каждая вершина расположена в точках с целочисленными координатами, в пространствах с числом измерений от [math]1[/math] до [math]3[/math]. Дадим описание каждой из групп.

Первая группа — вершины, которым соответствует операция скалярного умножения вектора на себя. На графе они располагаются в одномерной области. [math]i[/math] изменяется от [math]1[/math] до [math]k[/math].

Значениями аргументов для этих функций являются:

- при [math]i = 1[/math] — входные данные [math]\{a_{1p}\}, p = 1..n[/math];

- при [math]i \gt 1[/math] — результат выполнения функции в вершине пятой группы с координатами [math]\{i-1,1,p\}, p = 1..n[/math].

Результат этих операций является промежуточным данным алгоритма.

Вторая группа — вершины, которым соответствует операция SQRT извлечения квадратного корня. Они расположены в одномерной области, [math]i [/math] изменяется от [math]1[/math] до [math]k[/math].

Значением аргумента для этих функций является результат выполнения функции в вершине первой группы, с координатой [math]i[/math].

Результат является промежуточным данным алгоритма.

Третья группа — вершины, которым соответствует операция деления. Располагаются в двумерной области, [math]i[/math] изменяется от [math]1[/math] до [math]k[/math], [math]p[/math] изменяется от [math]1[/math] до [math]n[/math].

Значениями аргументов для этих функций являются:

- делимое:

- при [math]i = 1[/math] — входные данные [math]a_{1p}[/math];

- при [math]i \gt 1[/math] — результат выполнения функции в вершине пятой группы с координатами [math]i-1,1,p[/math];

- делитель - результат выполнения функции в вершине второй группы с координатой [math]i[/math].

Результат является выходным данным алгоритма [math]q_{ip}[/math].

Четвертая группа — вершины, которым соответствует операция скалярного умножения векторов [math]\mathbf{a}\cdot\mathbf{b}[/math]. Располагаются в двумерной области, [math]i[/math] изменяется от [math]1[/math] до [math]k-1[/math], [math]j[/math] изменяется от [math]1[/math] до [math]k-i[/math].

Значениями аргументов для этих функций являются:

- [math]\mathbf{a}[/math] — входные данные [math]\{a_{1+j,p}\},p = 1..n [/math];

- [math]\mathbf{b}[/math] — результат выполнения функции в вершине третьей группы с координатой [math]\{i,p\}, p = 1..n [/math].

Результат является промежуточным данным алгоритма.

Пятая группа — вершины которые соответствуют операции [math]a - b c[/math]. Располагаются в трехмерной области, [math]i[/math] изменяется от [math]1[/math] до [math]k-1[/math], [math]j[/math] изменяется от [math]1[/math] до [math]k-i[/math], [math]p[/math] изменяется от [math]1[/math] до [math]n[/math].

Значениями аргументов для этих функций являются:

- [math]a[/math]:

- при [math]i = 1[/math] — входные данные [math]a_{1+j,p}[/math];

- при [math]i \gt 1[/math] — результат выполнения функции в вершине пятой группы с координатами [math]i-1,j+1,p[/math];

- [math]b[/math] — результат выполнения функции в вершине четвертой группы, с координатами [math]i,j[/math];

- [math]c[/math] — результат выполнения функции в вершине третьей группы с координатой [math]i,p[/math].

Результат является промежуточным данным алгоритма.

Описанный граф для случая [math]k = 3[/math], [math]n = 3[/math] изображен на рисунке. Каждая группа вершин отличается цветом и буквенным обозначением. "S" — первая группа, "SQ" — вторая группа, "Div" — третья группа, "Dot" — четвертая группа, "f" — пятая группа. Квадратные метки синего и розового цветов обозначают передачу входных и выходных данных соответственно.

1.8 Ресурс параллелизма алгоритма

Для построения ортонормированного базиса методом Грама–Шмидта необходимо выполнить следующие ярусы операций:

- [math]k[/math] ярусов вычисления скалярных произведений векторов на самих себя (по одной операций на каждом, сложность операции по высоте и по ширине ЯПФ — [math]O(n)[/math] и [math]O(1)[/math] соответственно);

- [math]k[/math] ярусов вычисления квадратного корня (по одной операции на каждом);

- [math]k[/math] ярусов деления (по [math]n[/math] операций на каждом);

- [math]k-1[/math] ярус вычисления скалярных произведений пары векторов (от [math]1[/math] до [math](k-1)[/math] операций на каждом,сложность операции по высоте ЯПФ — O(n), по ширине - O(1));

- [math]k-1[/math] ярус умножения/вычитания чисел (от [math]n[/math] до [math](k-1)n[/math] операций на каждом).

В этом случае сложность алгоритма при классификации по высоте ЯПФ — [math]O(kn)[/math], при классификации по ширине ЯПФ — [math]O(kn)[/math].

1.9 Входные и выходные данные алгоритма

Входные данные: матрица [math]A[/math] с элементами [math]\alpha_{ij}[/math], где [math]i[/math] принимает значения [math]1,\ldots,k[/math], [math]j[/math] принимает значения [math] 1,\ldots,n[/math]. Здесь [math]k\leqslant n[/math]. По строкам этой матрицы записаны [math]k[/math] линейно-независимых векторов некоторого пространства размерности [math]n[/math].

Объем входных данных: [math]kn[/math].

Выходные данные: матрица [math]Q[/math] с элементами [math]\gamma_{ij}[/math]. Строки этой матрицы также задают [math]k[/math] векторов единичной длины размерности [math]n[/math], причем всякое скалярное произведение двух различных векторов этой системы равно [math]0[/math].

Объем выходных данных: [math]kn[/math].

Замечание: Алгоритм может работать с вырожденной матрицей, он выдаёт нулевую строку на шаге [math]j[/math], если строка [math]j[/math] матрицы [math]A[/math] является линейной комбинацией предыдущих строк. В этом случае для корректного продолжения работы алгоритма необходима дополнительная проверка на равенство строки нулю и пропуск соответствующих строк. Количество построенных векторов будет равняться размерности пространства, порождаемого строками матрицы.

1.10 Свойства алгоритма

Отношение последовательной и параллельной сложности алгоритма в случае неограниченных ресурсов равно [math]\dfrac{k^2n}{kn}=k[/math]. Вычислительная мощность алгоритма линейная.

Алгоритм почти полностью детерминирован — единственность результата выполнения гарантирована, однако возможно накопление ошибок округления.

Алгоритм является численно неустойчивым — ошибки округления могут привести к неортогональности полученных векторов.

Большинство дуг информационного графа являются локальными. Исключение составляют дуги исходящие из операций деления и извлечения корня — для первой группы количество дуг пропорционально квадрату количества векторов, а для второй — пропорционально размерности пространства, в котором заданы эти вектора. Возникающие при это длинные дуги могут быть заменены несколькими короткими пересылками между соседями.

2 Программная реализация алгоритма

2.1 Особенности реализации последовательного алгоритма

2.2 Локальность данных и вычислений

2.3 Возможные способы и особенности параллельной реализации алгоритма

Анализ последовательной реализации алгоритма Грама-Шмидта с помощью инструмента callgrind показывает, что наибольшую долю [math]\big([/math]более 97% для [math]k=n=512\big)[/math] процессорного времени использует процесс вычитания проекций нормированного вектора от остальных векторов. Этот процесс состоит из вложенных циклов - в одном из циклов происходит итерация по векторам, а в другом — по подпространствам. Таким образом, задача допускает следующие варианты параллельных реализаций:

- Распараллеливание по векторам.

Векторы распределяются по MPI-процессам. После нормировки очередного вектора процесс рассылает его остальным с помощью процедур групповой коммуникации. В исследуемой реализации используется вызов MPI_Bcast.

- Распараллеливание по векторам (b).

Так как рассылать очередной вектор необходимо не всем процессам, а только тем, которые содержат ещё не обработанные векторы, перед вызовом Bcast можно создавать новый коммуникатор, содержащий только необходимые процессы. Оптимальность данного способа реализации не исследовалась.

- Распараллеливание по подпространствам.

Так как последовательная программа содержит операции скалярного произведения, можно назначить каждому MPI-процессу некоторое подпространство. Скалярное произведение при этом подсчитывается при помощи операции Allreduce. Данная реализация является менее оптимальной, так как содержит [math]\frac{k(k-1)}{2}[/math] операций групповой коммуникации, в отличие от k операций для предыдущих реализаций.

Недостаток параллельной реализации классического алгоритма Грама-Шмидта[16] в том, что для матриц с высоким числом обусловленности на входе, система векторов на выходе алгоритма не всегда ортогональна[17].

Итеративно-параллельный классический алгоритм Грама-Шмидта cодержит процедуру итеративной реортогонализации, который даёт возможность избежать недостатков предыдущего метода[18].

Блочно-параллельный алгоритм Грама-Шмидта[19] — версия параллельного алгоритма Грама-Шмидта, использующая оптимизированные по использованию кэша матричные операции[20][21].

2.4 Масштабируемость алгоритма и его реализации

Проводились исследования двух параллельных реализаций метода ортогонализации Грама-Шмидта с использованием OpenMP и MPI.

Для OpenMP версии проводились испытания на суперкомпьютере IBM Regatta суперкомпьютерного комплекса Московского университета

Код был скомпилирован gcc 4.3.2, стандарт c++11, с флагом -O3. со следующими значениями параметров:

- число процессоров [1:16] с шагом 1;

- размер матрицы [192:3072] с шагом 192.

В результате экспериментов получен следующий диапазон значений эффективности реализации алгоритма:

- минимальная эффективность реализации 0.20%;

- максимальная эффективность реализации 11.18%.

На рисунках приведены графики производительности и эффективность исследованной реализации алгоритма в зависимости от числа процессоров и размера матрицы.

Оценим значения масштабируемости данной реализации:

- По размеру задачи: 0.0002905. При увеличении размерности задачи эффективность алгоритма медленно возрастает. Если рассматривать изменение эффективности при фиксированном числе процессоров, то большему числу процессоров соответствует более быстрый рост эффективности, начинающийся от более низкого начального значения. Малое значение масштабируемости по этому параметру говорит о слабом росте во всей области рассмотренных параметров.

- По числу процессоров: -0.0002463. С увеличением значения этой характеристики наблюдается слабое снижение эффективности работы параллельной реализации алгоритма. Эффективность снижается на всей области параметров, однако при большей размерности задачи явление начинает проявляться при больших значениях числа процессоров. Это связано с ростом накладных расходов на обеспечение их работы и взаимодействия. При слишком высоком числе процессоров, использованных для решения задачи малой размерности на эти побочные расходы может приходиться основная доля задействованных ресурсов.

- По двум направлениям: 0.0000015. Еще более низкий по сравнению с предыдущими характеристиками порядок этой величины свидетельствует о том, что рост эффективности при одновременном увеличении параметров запуска на значения соответствующих шагов хотя и присутствует, но является практически незначительным.

Для MPI версии испытания проводились на суперкомпьютере "Ломоносов" Суперкомпьютерного комплекса Московского университета. Для компиляции параллельной программы использовалась версия компилятора intel/13.1.0 с ключом компиляции -O3, стандарт c++11, версия библиотеки Intel MPI impi/4.0.3, запуск проводился на очереди test со следующими значениями параметров:

- число процессоров [8:128] с шагом 8;

- размер матрицы [256:3840] с шагом 256.

В результате экспериментов получен следующий диапазон значений эффективности реализации алгоритма:

- минимальная эффективность реализации 0.008%;

- максимальная эффективность реализации 10.00%.

На рисунках приведены графики производительности и эффективность исследованной реализации алгоритма в зависимости от числа процессоров и размера матрицы.

Аналогично с предыдущей, оценим значения масштабируемости данной реализации, поведение алгоритма во многом схоже:

- По размеру задачи: 0.0001318. Аналогично OpenMP, при увеличении размерности задачи эффективность алгоритма возрастает, несмотря на разброс значений. Большему числу процессоров также соответствует более быстрый рост эффективности. Малое положительное значение масштабируемости по этому параметру говорит о слабом росте во всей области рассмотренных параметров.

- По числу процессоров: -0.0003073. Снижение эффективности реализации алгоритма также связано с растущими накладными расходами, в частности на пересылки данных между процессорами.

- По двум направлениям: -0.000006103. По сравнению с OpenMP реализацией здесь общая масштабируемость имеет отрицательное значение, однако столь же малое абсолютное значение. Общее снижение эффективности с одновременным увеличением параметров выполнения алгоритма слабо выражено.

Число математических операций в исследуемом параллельном алгоритме пропорционально [math]\frac{1}{p}[/math], где [math]p[/math] - число параллельных процессов, поэтому для большого числа процессов значительное время занимают операции групповой коммуникации.

Эффективность работы процедуры MPI_Bcast зависит от топологии коммуникационной сети. Например, передача данных между ядрами одного узла происходит на порядки быстрее, чем на ядра соседнего узла. Таким образом, MPI_Bcast работает наиболее эффективно, когда задействованы все ядра некоторого числа узлов.

Мы предполагаем, что множественные особенности графиков для реализации с MPI связаны с тем, что на некоторых конфигурациях запуска были загружены не все ядра одного из узлов. Кроме того, если число векторов не делилось на число процессов, некоторые процессы хранили меньше векторов, чем остальные, что уменьшало эффективность работы параллельного алгоритма.

Исследованные реализации алгоритма

2.5 Динамические характеристики и эффективность реализации алгоритма

2.6 Выводы для классов архитектур

2.7 Существующие реализации алгоритма

Для классического метода ортогонализации Грама–Шмидта существуют реализации в математических программных пакетах, таких как

Также метод реализован в библиотеке SpectralPython для языка Python. Для устранения проблемы ошибок численных округлений иногда используется повторное применение метода к уже построенному ортогональному базису.

Поскольку метод ортогонализации Грама–Шмидта гарантирует получение [math]j[/math] ортогональных векторов к концу шага [math]j[/math], а не в самом конце работы алгоритма, используется в итерационных методах, таких как метод Арнольди. Для поддержки работы этого метода реализация ортогонализации Грама–Шмидта включена в библиотеку ARPACK.

3 Литература

- ↑ Математическая энциклопедия / Гл. ред. И. М. Виноградов — М.: Советская энциклопедия — Т.4 Ок–Сло, 1984. — 215 с.

- ↑ А. Е. Умнов. Аналитическая геометрия и линейная алгебра — 3-е издание, исправленное и дополненное — М.: МФТИ — 2011 — 544 c.

- ↑ 3,0 3,1 Meyer C. D. Matrix analysis and applied linear algebra. — Siam, 2000. — Т.2.

- ↑ Gram J. P. Ueber die Entwickelung reeller Functionen in Reihen mittelst der Methode der kleinsten Quadrate. — Journal für die reine und angewandte Mathematik. — 1883. — Т. 94. — pp. 41–73.

- ↑ Marquis de Laplace P. S. Théorie analytique des probabilités. — V. Courcier, 1820.

- ↑ 6,0 6,1 Erchard Shmidt. Mathematische Annalen Zur Theorie der linearen und nichtlinearen Integralgleichungen, 1. Teil: Entwicklung willkürlicher

Funktionen nach Systemen vorgeschriebener. — Mathematische Annalen. — 1908. — V. 65. — №. 3. — pp. 370-399. Ошибка цитирования Неверный тег

<ref>: название «Shmidt» определено несколько раз для различного содержимого - ↑ Краснов М.Л. Интегральные уравнения. Введение в теорию. — М.: Наука, 1975. — 302 с.

- ↑ Марченко В.А. Введение в теорию обратных задач спектрального анализа. — Харьков: Акта, 2005. — 143 с.

- ↑ О некоторых неравенствах, относящихся к определенным интегралам. Записки Академии наук по физико-математическому отделению. Серия 8. Т. 6 № 6. — C. 1–53.

- ↑ Nussbaum S., Menz G. Object-based image analysis and treaty verification: new approaches in remote sensing-applied to nuclear facilities in Iran. — Springer Science & Business Media, 2008 — pp 75–81.

- ↑ Gopi E. S. Algorithm collections for digital signal processing applications using matlab. — Springer Science & Business Media, 2007.

- ↑ Rajasekaran S., Suresh D., Pai G. A. V. Application of sequential learning neural networks to civil engineering modeling problems. — Engineering with Computers. — 2002. — Т. 18. — №. 2. — pp. 138–147.

- ↑ Воеводин В.В. Математические основы параллельных вычислений. — М.: Изд. Моск. ун-та, 1991. — 345 с.

- ↑ Воеводин В.В., Воеводин Вл.В. Параллельные вычисления. — СПб.: БХВ - Петербург, 2002. — 608 с.

- ↑ Фролов А.В.. Принципы построения и описание языка Сигма. Препринт ОВМ АН N 236. М.: ОВМ АН СССР, 1989.

- ↑ Dongarra J., Madsen K., Wasniewski J. Applied Parallel Computing: State of the Art in Scientific Computing. – Springer Science & Business Media, 2006. – V. 3732.

- ↑ Björck Å. Numerics of gram-schmidt orthogonalization //Linear Algebra and Its Applications. – 1994. – V. 197. – pp. 297-316.

- ↑ Giraud L., Langou J., Rozloznık M. On the round-off error analysis of the Gram-Schmidt algorithm with reorthogonalization. — Technical Report TR/PA/02/33, CERFACS, Toulouse, France, 2002.

- ↑ Vanderstraeten D. An accurate parallel block Gram–Schmidt algorithm without reorthogonalization. — Numerical linear algebra with applications.' — 2000. — V. 7. — №. 4. — pp. 219-236.

- ↑ Dongarra J. J. et al. An extended set of Fortran basic linear algebra subroutines — ACM Trans. Math. Soft. — 1988. — V. 14. — №. 1. — pp. 1-17.

- ↑ Dongarra J. J. et al. A set of level 3 basic linear algebra subprograms. — ACM Transactions on Mathematical Software (TOMS) — 1990. — V. 16. — №. 1. — pp. 1-17.