Участник:EasyBreezy/Стабилизированный метод бисопряженных градиентов (BiCGSTAB)

< Участник:EasyBreezy

Перейти к навигации

Перейти к поиску

Версия от 23:59, 15 октября 2016; Novikov alexander (обсуждение | вклад) (→Ресурс параллелизма алгоритма)

Основные авторы описания:

Содержание

- 1 Свойства и структура алгоритма

- 1.1 Общее описание алгоритма

- 1.2 Математическое описание алгоритма

- 1.3 Вычислительное ядро алгоритма

- 1.4 Макроструктура алгоритма

- 1.5 Схема реализации последовательного алгоритма

- 1.6 Последовательная сложность алгоритма

- 1.7 Информационный граф

- 1.8 Ресурс параллелизма алгоритма

- 1.9 Входные и выходные данные алгоритма

- 1.10 Свойства алгоритма

- 2 Программная реализация алгоритма

- 2.1 Особенности реализации последовательного алгоритма

- 2.2 Локальность данных и вычислений

- 2.3 Возможные способы и особенности параллельной реализации алгоритма

- 2.4 Масштабируемость алгоритма и его реализации

- 2.5 Динамические характеристики и эффективность реализации алгоритма

- 2.6 Выводы для классов архитектур

- 2.7 Существующие реализации алгоритма

- 3 Литература

1 Свойства и структура алгоритма

1.1 Общее описание алгоритма

- Стабилизированный метод бисопряженных градиентов, так же известный как BiCGSTAB (Biconjugate gradient stabilized method), был предложен голландским математиком Хенком ван дер Ворстом в 1992 году. Статья, в которой описывался метод, стала самым цитируемым научным трудом в области математики в 1990х годах.

- Метод появился, как ответ на задачу о построении способа решения систем линейных алгебраических уравнений произвольного вида. На момент появления BiCGSTAB уже существовали методы решения СЛАУ произвольного типа, в том числе и в комплексном пространстве, например метод бисопряженных градиентов. Однако существующие на тот момент методы либо обладали недостаточной скоростью сходимости, либо использовали в вычислениях тяжелые операции, такие как транспонирования матрицы, которые усложняли распараллеливание на многопроцессорных машинах.

- BiCGSTAB является итерационным методом решения систем линейных алгебраических уравнений. Мощь метода заключается в том, что его можно применять к матрицам общего вида, в том числе с комплексными коэффициентами. В процессе выполнения BiCGSTAB не использует для вычисления плохо распараллеливаемых операций, не допускает накопления погрешностей округления и нестабильного поведения невязки. Эти факторы выгодно отличают его от предшественников: метода бисопряженных градиентов и квадратичного метода сопряженных градиентов, из которого BiCGSTAB фактически и вытекает. К преимуществам так же можно добавить более высокую в общем случае скорость сходимости относительно ближайших конкурентов. Тем не менее, для некоторых видов СЛАУ BiCGSTAB может уступать более простым методам.

- Благодаря свойствам алгоритма область применения метода весьма широка. Фактически, он используется во всех задачах, где требуется решать СЛАУ, в том числе СЛАУ большой размерности, к которым сводится большое количество численных методов, применяемых при решении задач математического моделирования.

- BiCGSTAB относится к классу так называемых проекционных методов. Основная идея методов данного класса: искать итерационным способом наилучшее приближение решения в некотором подпространстве пространства R^n, и чем шире подпространство, в котором ищется приближение решения, тем ближе будет приближенное решение к точному на каждой итерации. В качестве такого подпространства используются пространства Крылова, порожденные матрицей системы и невязкой первого приближения: K^m (A, r^0) = span(r^0, Ar^0, A^2r^0, ..., A^{m-1} r^0).

- Изложим основную идею любого проекционного метода, заложенную в том числе и в BiCGSTAB. Для простоты выкладок и рассуждений здесь и далее будем считать, что матрица системы и ее правая часть вещественны. Без ограничения общности все дальнейшие рассуждения могут быть перенесены и на комплексный случай. Итак, пусть решается система Ax=b с невырожденной матрицей A \in R^{n \times n} и ненулевым вектором b \in R^n. Имеются два подпространства K_n и L_n. Требуется найти вектор x \in K_n, который обеспечивает решение системы, оптимальное относительно подпространства L, то есть требуется выполнение условия Петрова-Галеркина: (Ax,z)=(b,z), \forall z \in L_n. В данном случае вектор x называется обобщенным решением системы.

- Условие Петрова-Галеркина можно записать и через определение невязки. Пусть r = b - Ax - невязка, тогда условие Петрова-Галеркина перепишется в виде: (b - Ax, z)=(r, z),\forall z \in L_n. Это равносильно тому, что вектор невязки ортогонален пространству L_n.

- Пусть для СЛАУ известно некоторое приближение x^0 точного решения x^*. Данное приближение требуется уточнить поправкой \delta: b - Ax^0 + \delta \perp L. Невязка уточненного решения имеет вид: r_{new} = b - Ax^0 + \delta = r^0- A\delta. Условие Петрова-Галеркина тогда можно переписать так: (r_{new}, z)= r^0 - (A\delta, z) = 0, \forall z \in L

- Пусть dim K = dim L = m, V = (v_1, ..., v_n) \in R^{n \times m}, W = (w_1, ... w_n) \in R^{n \times m}, где V и W – матрицы, столбцы которых образуют базисы пространств K и L соответственно. Пусть так же \delta = Vy, z = Wq, где y – коэффициенты разложения вектора поправки по базису пространства K, а q – коэффициенты разложения вектора z в пространстве L. Тогда новое приближение решения можно записать в виде: x^1 = x^0 + \delta= x^0 + Vy. Из условия ортогональности Петрова-Галеркина получаем, что: (r - AVy, Wq) = (W^Tr^0 - AVy, q) = 0. Поскольку q \neq 0, то получаем СЛАУ для вектора y: W^TAVy = W^Tr^0. Если предположить, что матрица W^TAVy невырождена, то вектор y однозначно определяется и равен: y = W^TAV^{-1}W^Tr^0. Подставляя найденные коэффициенты разложения в выражение для первого приближения получаем: x^1 = x^0 + \delta = x^0 + W^TAV^{-1}W^Tr^0y

- Подведем итог. Общий порядок шагов любого проекционного метода следующий:

- Выбрать пару подпространств K и L

- Найти базис V пространства K и базис W пространства L;

- Вычислить невязку

- Найти y = W^T AV^{-1} W^T r^0

- Положить x = x + Vy

- Если не достигнут критерий остановки итерационного процесса, то повторить алгоритм, начиная с первого шага.

- Как будет показано далее, в BiCGSTAB не требуется вычислять матрицу W^T AV^{-1} в явном виде.

1.2 Математическое описание алгоритма

- Рассмотрим СЛАУ с вещественными коэффициентами:

- В основу алгоритма ложиться идея проекционного метода и использование свойства A-бисопряженности системы векторов, а именно: векторы p^1, p^2, ... и \overline p^1, \overline p^2, ... бисопряжены, если (Ap^i,p^j ) = 0, при i \neq j. Фактически, данное условие эквивалентно биортогональности относительно энергетического скалярного произведения.

- Общая концепция проекционных методов предписывает нам выбрать два подпространства. В нашем случае подпространства мы выберем два подпространства, задаваемые матрицей системы А, вектором невязки на нулевой итерации r^0 и вектором \overline r^0. который выбирается из условия (r^0, \overline r^0) \neq 0:

- Метод основан на построении биортогонального базиса p^0, p^1, ... p^k .. пространства K^k (A, r^0) и вычислении поправки такой, что новое приближение на очередной итерации было бы ортогонально второму подпространству Крылова. Базисные вектора строятся до тех пор, пока не будет достигнут критерий остановки итерационного процесса, а каждое последующее приближение формируется, как сумма приближения на предыдущей итерации и найденной поправки. Критерием останова итерационного процесса является достижения невязкой значения, которое меньше некоторого наперед заданного числа \epsilon.

- Основной итерационный процесс задается формулами:

- где:

- x^{k + 1} - приближение на следующей итерации

- x^k - приближение на предыдущей итерации

- p_k - базисный вектор подпространства Крылова, порожденного матрице СЛАУ и невязкой

- \alpha_k, \omega_k - вспомогательные скаляры, определяемые для каждого шага итерации

- s_k - вспомогательный вектор

- p^{k + 1} - k + 1-ый базисный вектор

- r^{k + 1} - невязка k + 1-ой итерации

- \beta_k - вспомогательный коэффициент

- Вспомогательный вектор выражается следующим образом:

- s_k = r^k - \alpha_k Ap_k

- Вспомогательные коэффициенты вычисляются по формулам:

- \alpha_k = \frac{(r^k, \overline r^0}{(Ap_k, \overline r^0)}

- \omega_k = \frac{(As_k, s_k)}{(As_k, As_k)}

- \beta_k = \frac{(r^{k + 1}, \overline r^0)}{(r^k, \overline r^0}

- Подведем итог и запишем итерационный процесс

- Подготовительный этап:

- Выбирается некоторое начальное приближение x^0

- По выбранному приближению находится невязка r^0 = b - Ax^0

- Из условия (r^0, \overline r^0) \neq 0 выбирается вектор \overline r^0

- Положим p^0 = r^0

- Устанавливаем счетчик итераций: n = 0

- Итерационный процесс:

- Находим \alpha_k

- По найденному \alpha_k вычисляем s_k

- По найденному s_k вычисляется вспомогательный коэффициент \omega_k

- Находится новое приближение x^{k + 1}

- Вычисляется невязка r^{k + 1}. Если выполнено условие \parallel r^{k + 1} \parallel \lt \epsilon, то алгоритм завершается.

- Вычисляется вспомогательный коэффициент \beta_k

- Вычисляется новый базисный вектор: p^{k + 1}

- Увеличивается номер итерации: n = n + 1

- Переход к первому шагу итерационного процесса.

1.3 Вычислительное ядро алгоритма

- Вычислительное ядро полностью совпадает с итерационным процессом. Подготовка к итерационному процессу в ядро не включается.

1.4 Макроструктура алгоритма

На каждой итерации алгоритма используются:

- Трижды Скалярное произведение векторов, вещественная версия, последовательно-параллельный вариант

- Единожды Умножение плотной матрицы на вектор

1.5 Схема реализации последовательного алгоритма

1.6 Последовательная сложность алгоритма

- Всего в вычислительном блоке алгоритма присутствует 20 трудоемких операций: 2 операции умножения матрицы на вектор, 6 скалярных произведений и 6 сложений/вычитаний векторов и 6 умножений вектора на число.

- Каждое скалярное произведение требует n произведений и n - 1 сложение, то есть 2n - 1 операции. Скалярных произведений всего 6 штук (включая поиск нормы), что дает нам 12n - 6 операций.

- Умножение матрицы размерности n \times n на вектор эквивалентно взятию еще n скаляров, и так как таких операций в вычислительном ядре 2, то дополнительно имеется еще 2n(2n - 1) операций.

- Наконец, сложение или вычитание векторов требует 6n соотвествующих операций. Столько же требует 6 произведений вектора на число.

- Итого: 2n(2n - 1) + 12n - 6 + 6n + 6n = 4n^2 + 22n - 6 операций.

- Нетрудоемкие операции, вроде извлечение квадратного корня и деление вещественных чисел друг на друга, не принимаются в расчет, так как они не влияют на итоговый результат. Окончательно можно заключить, что последовательная сложность алгоритма эквивалента O(n^2)

1.7 Информационный граф

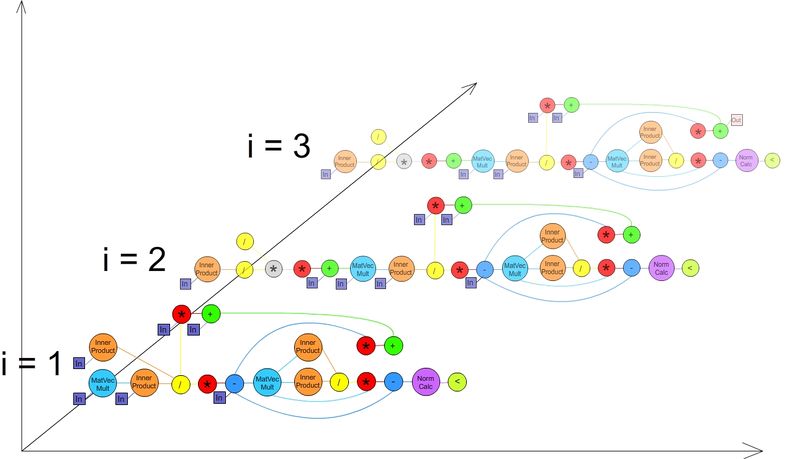

Информационный граф. На графе представлены связи между операциями, выполняющимися в первых трех итерациях метода. При выполнении большего, чем 3, количества итераций, структура каждой новой будет повторять структуру третьей. Связи между итерациями не представлены, т.к. они не важны для понимания параллельной структуры алгоритма.

1.8 Ресурс параллелизма алгоритма

Основной прирост производительности параллельной версии алгоритма дает использование параллельных операций вычисления скалярного произведения. Каждая из них, выполняемая на p процессорах, за счет метода сдваивания может ускориться до \log_2 p раз. То же касается и параллельных сложений векторов.

1.9 Входные и выходные данные алгоритма

- Входные данные

- Матрица A \in R^{N \times N} ( C^{N \times N} )

- Вектор правой части b \in R^N ( C^N )

- Выходные данные:

- Вектор решения СЛАУ x \in R^N ( C^N )

1.10 Свойства алгоритма

- BiCGSTAB хорошо зарекомендовал себя для решения систем линейных алгебраический уравнений, поскольку обладает некоторыми важными свойствами:

- Благодаря применению подхода Петрова-Галеркина и техники ортогонализации, он численно устойчив

- Не меняется вид матрицы в процессе решения

- Эффективен для решения систем большой размерности с разреженной матрицей, поскольку в методе самая трудоемкая операция - умножение матрицы на вектор

- Лучше подходит под распределенные системы, поскольку не содержит операции транспонирования матрицы

- Применим для решения систем с несимметричными матрицами.

2 Программная реализация алгоритма

2.1 Особенности реализации последовательного алгоритма

2.2 Локальность данных и вычислений

2.2.1 Локальность реализации алгоритма

2.2.1.1 Структура обращений в память и качественная оценка локальности

2.2.1.2 Количественная оценка локальности

2.2.1.3 Анализ на основе теста Apex-Map

2.3 Возможные способы и особенности параллельной реализации алгоритма

2.4 Масштабируемость алгоритма и его реализации

2.4.1 Масштабируемость алгоритма

2.4.2 Масштабируемость реализации алгоритма

2.5 Динамические характеристики и эффективность реализации алгоритма

2.6 Выводы для классов архитектур

2.7 Существующие реализации алгоритма

- Параллельная реализация алгоритма, предложенная MIT: MIT BiCGSTAB

- Параллельная реализация алгоритма в бесплатной библиотеке, поддерживающей MPI и OpenMP, HYPRE: Официальная страница Исходный код

- Параллельная реализация алгоритма на CUDA в условно бесплатной библиотеке NVIDIA AmgX: [1]